История развития средств вычислительной техники

Содержание:

Введение

Появление компьютеров (от англ. слова Compute — вычислять) — одна из существенных особенностей современного мира. Первоначальный смысл английского слова «компьютер» — это человек, производящий расчеты. Широкое распространение компьютеров привело к тому, что все большее число людей стали изучать основы вычислительной техники, а программирование постепенно превратилось из рабочего инструмента специалиста в элемент культуры. При этом история развития средств инструментального счета известна в значительно меньшей степени.

Изучение истории вычислительной техники необходимо для формирования мировоззрения, воспитания патриотизма на примерах выдающихся разработок отечественных ученых и инженеров, сохранения культурного наследия. Современный специалист должен знать историю своей отрасли, место и роль вычислительной техники в истории развития цивилизации. Кроме того, он должен иметь представление об основных этапах развития вычислительной техники и языков программирования.

Цель курсовой работы: изучение истории развития вычислительной техники.

Для достижения поставленной цели, следует решить следующие задачи:

- проанализировать литературные источники по рассматриваемому вопросу;

- изучить основные этапы развития вычислительной техники;

- познакомиться с характеристиками поколений ЭВМ;

- рассмотреть классификацию ЭВМ.

1 Периоды истории развития вычислительной техники

В истории развития вычислительной техники можно выделить четыре периода: домеханический, механический, электромеханический и электронно-вычислительный.

1.1. Домеханический период

В течение домеханического периода создавалась не вычислительная техника, а счетные устройства, древнейшими из которых являются разного вида счеты. Спустя 1000 лет, в XVII в., шотландец Джон Непер (1550—1617) изобрел устройство для выполнения умножения, известное как палочки Непера. В 1654 г. Р. Биссакар, а в 1657 г. С. Патридж независимо друг от друга разработали логарифмическую линейку. В конце XV в. Леонардо да Винчи разработал эскиз механического 13-разрядного суммирующего устройства.

1.2 Механический период

Первое в мире автоматическое устройство для выполнения операции сложения было создано на базе механических часов. В 1623 году его разработал Вильгельм Шикард, профессор кафедры восточных языков в университете Тюбингена (Германия). В наши дни рабочая модель устройства была воспроизведена по чертежам и подтвердила свою работоспособность. Сам изобретатель в письмах называл машину «суммирующими часами».

В 1642 году французский механик Блез Паскаль (1623-1662) разработал более компактное суммирующее устройство (рис. 2.1), которое стало первым в мире механическим калькулятором, выпускавшимся серийно (главным образом для нужд парижских ростовщиков и менял). В 1673 году немецкий математик и философ Г. В. Лейбниц (1646-1717) создал механический калькулятор, который мог выполнять операции умножения и деления путем многократного повторения операций сложения и вычитания.

На протяжении XVIII века, известного как эпоха Просвещения, появились новые, более совершенные модели, но принцип механического управления вычислительными операциями оставался тем же. Идея программирования вычислительных операций пришла из той же часовой промышленности. Старинные монастырские башенные часы были настроены так, чтобы в заданное время включать механизм, связанный с системой колоколов. Такое программирование было жестким — одна и та же операция выполнялась в одно и то же время.

Идея гибкого программирования механических устройств с помощью перфорированной бумажной ленты впервые была реализована в 1804 году в ткацком станке Жаккарда, после чего оставался только один шаг до программного управления вычислительными операциями.

Этот шаг был сделан выдающимся английским математиком и изобретателем Чарльзом Бэббиджем (1792-1871) в его Аналитической машине, которая, к сожалению, так и не была до конца построена изобретателем при жизни, но была воспроизведена в наши дни по его чертежам, так что сегодня мы вправе говорить об Аналитической машине, как о реально существующем устройстве. Особенностью Аналитической машины стало то, что здесь впервые был реализован принцип разделения информации на команды и данные. Аналитическая машина содержала два крупных узла — «склад» и «мельницу». Данные вводились в механическую память «склада» путем установки блоков шестерен, а потом обрабатывались в «мельнице» с использованием команд, которые вводились с перфорированных карт (как в ткацком станке Жаккарда).

Идея Чарльза Бэббиджа о раздельном рассмотрении команд и данных оказалась необычайно плодотворной. В XX веке она была развита в принципах Джона фон Неймана (1941), и сегодня в вычислительной технике принцип раздельного рас смотрения программ и данных имеет очень важное значение. Он учитывается и при разработке архитектур современных компьютеров, и при разработке компьютерных программ.

1.3 Электромеханический период

Электромеханический период развития вычислительной техники (ВТ) обусловлен развитием прикладной электротехники (электропривод и электромеханические реле), позволившей создавать электромеханические вычислительные устройства. Этот период охватывает приблизительно 60 лет — от создания Г. Холлеритом в 1888 г. электромеханической машины до 1944 г., когда была создана в США автоматическая управляемая вычислительная машина Г.Айкена MARK-1. В этой сфере работали ученые Конрад Цузе, Джон Атанасов, Алан Тьюринг, Джон фон Нейман и др.

1.4 Электронно-вычислительный период

Электронно-вычислительный период связан с развитием электроники и микроэлектроники и начинается созданием в США в 1946 г. первой ЭВМ — машины ENIAC (Electronic Numerical Integrator And Computer). Первоначально предназначавшаяся для решения задач баллистики, машина оказалась универсальной, т.е. способной решать различные задачи. За время короткой истории своего развития электронные вычислительные машины прошли значительную эволюцию, в которой можно выделить четыре поколения ЭВМ, временные рамки которых условны, поэтому могут различаться в разных источниках информации.

2 Поколения ЭВМ

Развитие ЭВМ делится на несколько периодов. Поколения ЭВМ каждого периода отличаются друг от друга элементной базой и математическим обеспечением.

2.1 Первое поколение

Первое поколение (1945-1954 гг.) - ЭВМ на электронных лампах (вроде тех, что были в старых телевизорах). Это начало эпохи становления вычислительной техники. Большинство машин первого поколения были экспериментальными устройствами и строились с целью проверки тех или иных теоретических положений. Вес и размеры таких машин требовали для себя отдельных зданий, и стали давно легендой.

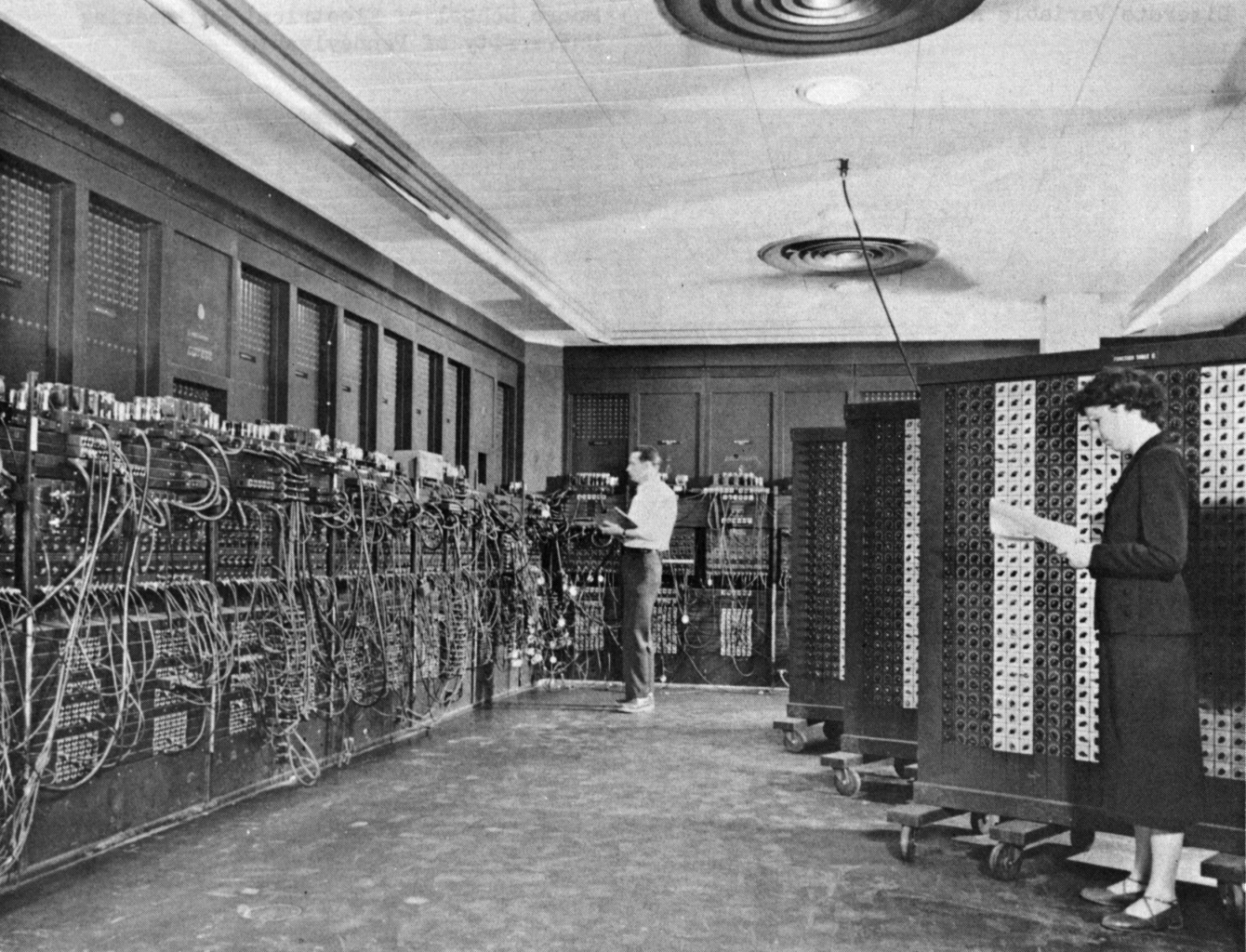

В 1946 году в США была создана первая электронная вычислительная машина (ЭВМ) - ENIAC (Electronic Numerical Integrator and Computer - Электронный числовой интегратор и компьютер) (рис. 1.). Разработчики: Джон Мочли (John Mauchly) и Дж. Преспер Эккерт (J. Prosper Eckert).

ENIAC был произведен на свет в Школе электрической техники Moore (при университете в Пенсильвании).

Время сложения - 200 мкс, умножения - 2800 мкс и деления - 24000 мкс.

Компьютер содержал 17468 вакуумных ламп шестнадцати типов, 7200 кристаллических диодов и 4100 магнитных элементов.

Общая стоимость базовой машины - 750000 долларов. Стоимость включала: дополнительное оборудование, магнитные модули памяти (по цене 29706,5 доллара) и аренду у IBM (по 82,5 доллара в месяц) устройства считывания перфокарт (125 карт в минуту). Она также включала и арендную плату (по 77 долларов в месяц) за IBM-перфоратор (100 карт в минуту).

Потребляемая мощность ENIAC - 174 кВт. Занимаемое пространство - около 300 кв. м.

Ввод чисел в первые машины производился с помощью перфокарт, а программное управление последовательностью выполнения операций осуществлялось, например в ENIAC, как в счетно-аналитических машинах, с помощью штекеров и наборных полей. Хотя такой способ программирования и требовал много времени для подготовки машины, то есть для соединения на наборном поле (коммутационной доске) отдельных блоков машины, он позволял реализовывать счетные "способности" ENIAC'а и тем выгодно отличался от способа программной перфоленты, характерного для релейных машин. Солдаты, приписанные к этой огромной машине, постоянно носились вокруг нее, скрипя тележками, доверху набитыми электронными лампами. Стоило перегореть хотя бы одной лампе, как ENIAC тут же останавливался, и начиналась суматоха: все спешно искали сгоревшую лампу. Одной из причин столь частой замены ламп - возможно, и не слишком достоверной, считалась такая: их тепло и свечение привлекали мотыльков, которые залетали внутрь машины и вызывали короткое замыкание. Если это правда, то термин "жучки" (bugs), под которым подразумевают ошибки в программных и аппаратных средствах компьютеров, приобретает новый смысл. Когда все лампы работали, инженерный персонал мог настроить ENIAC на какую-нибудь задачу, вручную изменив подключение 6 000 проводов. Все эти провода приходилось вновь переключать, когда вставала другая задача.

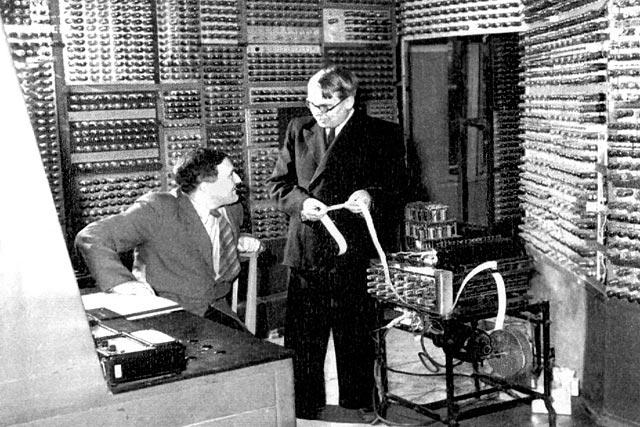

В Советском Союзе первая электронная цифровая вычислительная машина была разработана в 1950 году под руководством академика С. А. Лебедева в Академии наук Украинской ССР. Она называлась «МЭСМ» (малая электронная счётная машина) (рис. 2).

Рис. 2. Малая электронная счётная машина (МЭСМ)

МЭСМ была самой быстродействующей и практически единственной регулярно эксплуатируемой ЭВМ в Европе. МЭСМ разработана в Институте электроники Академии наук Украины под руководством академика Сергея Алексеевича Лебедева. Принципы построения МЭСМ были разработаны С.А. Лебедевым независимо от аналогичных работ на Западе. Коллектив сотрудников, создавших МЭСМ, стал ядром организованного на базе лаборатории С.А. Лебедева Вычислительного центра НАН Украины, а впоследствии - Института кибернетики им. В.М. Глушкова НАН Украины. Конструктивно она была изготовлена в виде макета.

Работа по созданию машины носила научно-исследовательский характер и имела целью экспериментальную проверку общих принципов построения универсальных ЦВМ.

Основные параметры машины таковы: быстродействие - 50 операций в 1 секунду; емкость оперативного ЗУ - 31 число и 63 команды; представление чисел - 16 двоичных разрядов с фиксированной перед старшим разрядом запятой; команды трехадресные, длиной 20 двоичных разрядов (из них 4 разряда - код операции); рабочая частота - 5 килогерц; машина имела также постоянное (штекерное) ЗУ на 31 число и 63 команды; была предусмотрена также возможность подключения дополнительного ЗУ на магнитном барабане, емкостью в 5000 слов. ОЗУ было построено на триггерных регистрах, АУ - параллельного действия, чем в основном, и объясняются сравнительно большие аппаратурные затраты (только в ОЗУ было использовано 2500 триодов и 1500 диодов). Потребляемая мощность составляла 15 кВт, машина размещалась на площади 60 кв.м.

Машины этого поколения: «ENIAC», «МЭСМ», «БЭСМ», «IBM -701», «Стрела», «М-2», «М-3», «Урал», «Урал-2», «Минск-1», «Минск-12», «М-20» и др. Эти машины занимали большую площадь, использовали много электроэнергии и состояли из очень большого числа электронных ламп. Например, машина «Стрела» состояла из 6400 электронных ламп и 60 тыс. штук полупроводниковых диодов. Их быстродействие не превышало 2…3 тыс. операций в секунду, оперативная память не превышала 2 Кб. Только у машины «М-2» (1958 г.) оперативная память была 4 Кб, а быстродействие 20 тыс. операций в секунду.

2.2 Второе поколение

ЭВМ 2-го поколения были разработаны в 50-х – 60-х гг. В качестве основного элемента были использованы уже не электронные лампы, а полупроводниковые диоды и транзисторы, а в качестве устройств памяти стали применяться магнитные сердечники и магнитные барабаны — далекие предки современных жестких дисков. Второе отличие этих машин — это то, что появилась возможность программирования на алгоритмических языках. Были разработаны первые языки высокого уровня - Фортран, Алгол, Кобол. Эти два важных усовершенствования позволили значительно упростить и ускорить написание программ для компьютеров. Программирование, оставаясь наукой, приобретает черты ремесла. Все это позволило резко уменьшить габариты и стоимость компьютеров, которые тогда впервые стали строиться на продажу.

Машины этого поколения: «РАЗДАН-2», «IВМ-7090», «Минск-22,-32», «Урал- 14,-16», «БЭСМ-3,-4,-6», «М-220, -222» и др.

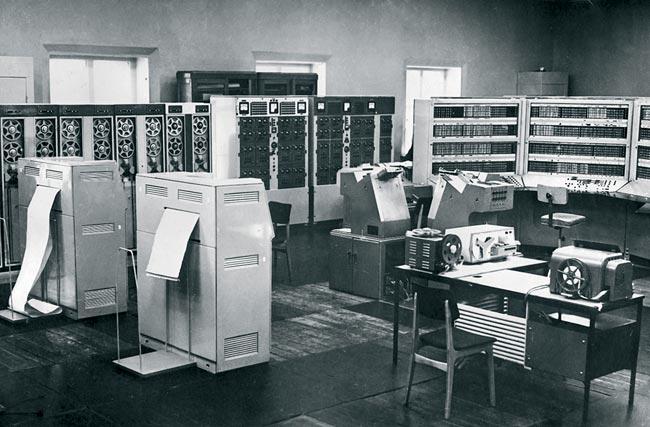

В структуре БЭСМ-6 (рис. 3) впервые в отечественной практике и независимо от зарубежных ЭВМ (STRETCH фирмы IBM) был широко использован принцип совмещения выполнения команд (до 14 одноадресных машинных команд могли находиться на разных стадиях выполнения). Этот принцип, названный главным конструктором БЭСМ-6 академиком С. А. Лебедевым принципом "водопровода", стал впоследствии широко использоваться для повышения производительности универсальных ЭВМ, получив в современной терминологии название конвейера команд.

Работа модулей оперативной памяти, устройства управления и арифметико-логического устройства осуществлялась параллельно и асинхронно, благодаря наличию буферных устройств промежуточного хранения команд и данных. Для ускорения конвейерного выполнения команд в устройстве управления были предусмотрены отдельная регистровая память хранения индексов, отдельный модуль адресной арифметики, обеспечивающий быструю модификацию адресов с помощью индекс-регистров, включая режим стекового обращения.

Ассоциативная память на быстрых регистрах (типа cache) позволяла автоматически сохранять в ней наиболее часто используемые операнды и тем самым, сократить число обращений к оперативной памяти. "Расслоение" оперативной памяти обеспечивало возможность одновременного обращения к разным ее модулям из разных устройств машины.

Применение полупроводников в электронных схемах ЭВМ привели к увеличению достоверности, производительности до 30 тыс. операций в секунду и оперативной памяти до 32 Кб. Уменьшились габаритные размеры машин и потребление электроэнергии. Но главные достижения этой эпохи принадлежат к области программ. На втором поколении компьютеров впервые появилось то, что сегодня называется операционной системой. Соответственно расширялась и сфера применения компьютеров. Теперь уже не только ученые могли рассчитывать на доступ к вычислительной технике; компьютеры нашли применение в планировании и управлении, а некоторые крупные фирмы даже компьютеризовали свою бухгалтерию, предвосхищая моду на двадцать лет.

Рис. 3. БЭСМ-6 — использовалась во всех отраслях народного хозяйства

2.3 Третье поколение

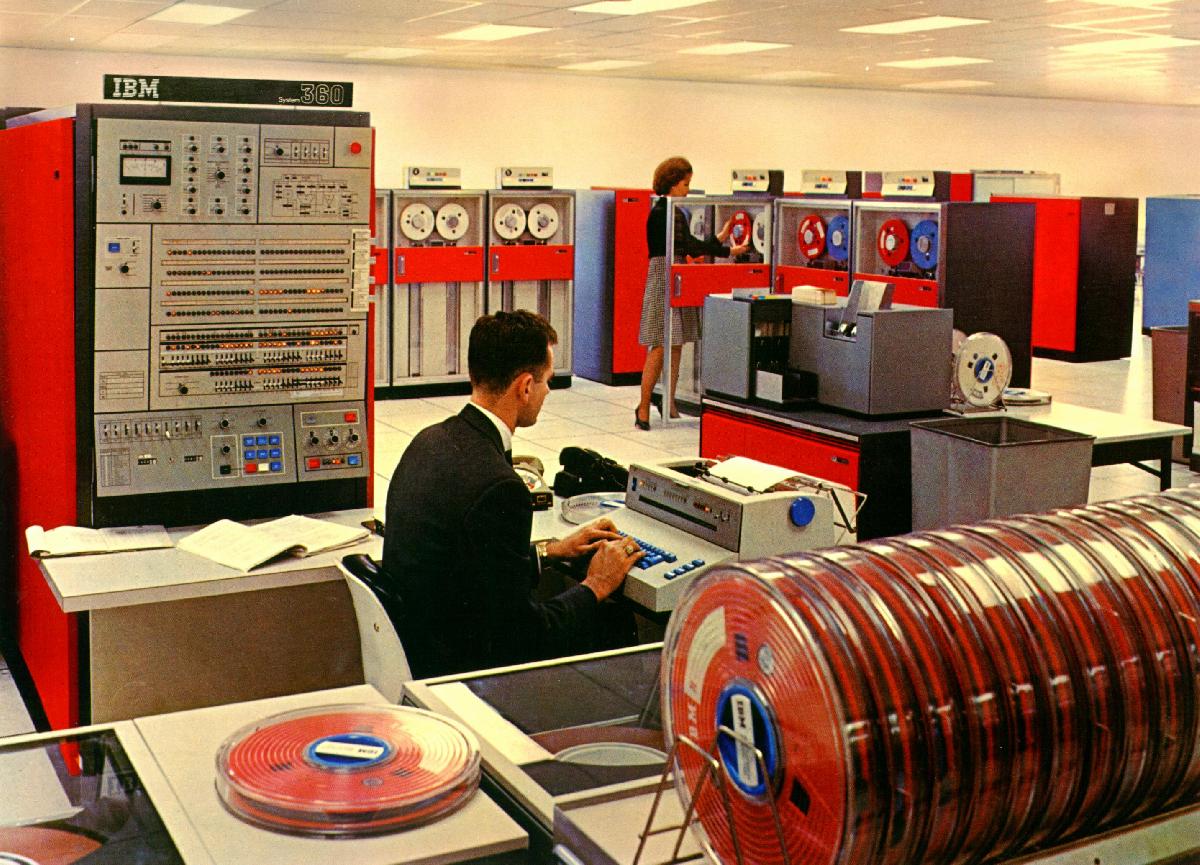

Разработка в 60-х годах интегральных схем - целых устройств и узлов из десятков и сотен транзисторов, выполненных на одном кристалле полупроводника (то, что сейчас называют микросхемами) привело к созданию ЭВМ 3-го поколения. В это же время появляется полупроводниковая память, которая и по сей день используется в персональных компьютерах в качестве оперативной. Применение интегральных схем намного увеличило возможности ЭВМ. Теперь центральный процессор получил возможность параллельно работать и управлять многочисленными периферийными устройствами. ЭВМ могли одновременно обрабатывать несколько программ (принцип мультипрограммирования). В результате реализации принципа мультипрограммирования появилась возможность работы в режиме разделения времени в диалоговом режиме. Удаленные от ЭВМ пользователи получили возможность независимо друг от друга оперативно взаимодействовать с машиной.

В эти годы производство компьютеров приобретает промышленный размах. Пробившаяся в лидеры фирма IBM, первой реализовала семейство ЭВМ - серию полностью совместимых друг с другом компьютеров от самых маленьких, размером с небольшой шкаф (меньше тогда еще не делали), до самых мощных и дорогих моделей. Наиболее распространенным в те годы было семейство System/360 фирмы IBM (рис. 4).

Начиная с ЭВМ 3-го поколения, традиционным стала разработка серийных ЭВМ. Хотя машины одной серии сильно отличались друг от друга по возможностям и производительности, они были информационно, программно и аппаратно совместимы. Например, странами СЭВ были выпущены ЭВМ единой серии («ЕС ЭВМ») «ЕС-1022», «ЕС-1030», «ЕС-1033», «ЕС-1046», «ЕС-1061», «ЕС-1066» и др. Производительность этих машин достигала от 500 тыс. до 2 млн. операций в секунду, объём оперативной памяти достигал от 8 Мб до 192 Мб.

К ЭВМ этого поколения также относится «IВМ-370», «Электроника — 100/25», «Электроника — 79», «СМ-3», «СМ-4» и др.

Для серий ЭВМ было сильно расширено программное обеспечение (операционные системы, языки программирования высокого уровня, прикладные программы и т.д.).

Невысокое качество электронных комплектующих было слабым местом советских ЭВМ 3-го поколения. Отсюда постоянное отставание от западных разработок по быстродействию, весу и габаритам, но, как настаивают разработчики СМ, не по функциональным возможностям. Для того, чтобы компенсировать это отставание, разрабатывались спецпроцессоры, позволяющие строить высокопроизводительные системы для частных задач. Оснащенная спецпроцессором Фурье-преобразований СМ-4, например, использовалась для радиолокационного картографирования Венеры.

Еще в начале 60-х гг. появляются первые миникомпьютеры - небольшие маломощные компьютеры, доступные по цене небольшим фирмам или лабораториям. Миникомпьютеры представляли собой первый шаг на пути к персональным компьютерам, пробные образцы которых были выпущены только в середине 70-х годов. Известное семейство миникомпьютеров PDP фирмы Digital Equipment послужило прототипом для советской серии машин СМ.

Между тем, количество элементов и соединений между ними, умещающихся в одной микросхеме, постоянно росло, и в 70-е годы интегральные схемы содержали уже тысячи транзисторов. Это позволило объединить в единственной маленькой детальке большинство компонентов компьютера - что и сделала в 1971 году фирма Intel, выпустив первый микропроцессор, который предназначался для только-только появившихся настольных калькуляторов. Этому изобретению суждено было произвести в следующем десятилетии настоящую революцию - ведь микропроцессор является сердцем и душой современного персонального компьютера.

Но и это еще не все - поистине, рубеж 60-х и 70-х годов был судьбоносным временем. В 1969 году зародилась первая глобальная компьютерная сеть - зародыш того, что мы сейчас называем Интернетом. И в том же 1969 году одновременно появились операционная система Unix и язык программирования С ("Си"), оказавшие огромное влияние на программный мир и до сих пор сохраняющие свое передовое положение.

К сожалению, начиная с середины 70-х годов стройная картина смены поколений нарушается. Все меньше становится принципиальных новаций в компьютерной науке. Прогресс идет в основном по пути развития того, что уже изобретено и придумано, - прежде всего за счет повышения мощности и миниатюризации элементной базы и самих компьютеров.

2.4 Четвертое поколение

Обычно считается, что период с 1975 года принадлежит компьютерам четвертого поколения. Их элементной базой стали большие интегральные схемы (БИС). В одном кристалле интегрировано до 100 тысяч элементов). Быстродействие этих машин составляло десятки млн. операций в секунду, а оперативная память достигла сотен Мб. Появились микропроцессоры (1971 г. фирма Intel), микро-ЭВМ и персональные ЭВМ. Стало возможным коммунальное использование мощности разных машин (соединение машин в единый вычислительный узел и работа с разделением времени).

В 1973 году фирма Intel выпустила процессор 8080, который мог адресовать 64 Кбайт памяти. Это был одним из самых серьезных шагов по пути к созданию современных персональных компьютеров. Фирма IBM выпустила свой первый персональный компьютер в 1975 году.

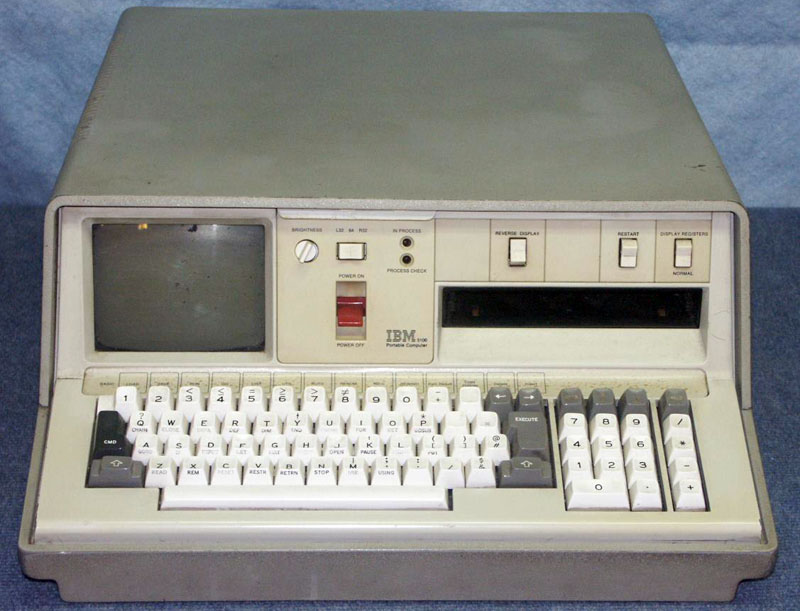

Рис. 5. Первый персональный компьютер IBM 5100

Модель 5100 (рис. 5) имела 16 Кбайт памяти, встроенный интерпретатор языка BASIC и встроенный кассетный лентопротяжный механизм, который использовался в качестве запоминающего устройства.

Многие полагают, что достижения периода 1975-1985 гг. не настолько велики, чтобы считать его равноправным поколением. Сторонники такой точки зрения называют это десятилетие принадлежащим "третьему-с половиной" поколению компьютеров. И только с 1985года, когда появились супербольшие интегральные схемы (СБИС), в кристалле которой размещается до 10 млн. элементов, следует отсчитывать годы жизни 4-го поколения ЗВМ, здравствующегося и по сей день.

Развитие ЭВМ 4-го поколения пошло по 2-м направлениям:

1-ое направление — создание суперЭВМ - комплексов многопроцессорных машин. Быстродействие таких машин достигает нескольких миллиардов операций в секунду. Они способны обрабатывать огромные массивы информации. Сюда входят комплексы ILLIAS-4, CRAY, CYBER, «Эльбрус-1», «Эльбрус-2» и др. Многопроцессорные вычислительные комплексы (МВК) "Эльбрус-2" активно использовались в Советском Союзе в областях, требующих большого объема вычислений, прежде всего, в оборонной отрасли. Вычислительные комплексы "Эльбрус-2" эксплуатировались в Центре управления космическими полетами, в ядерных исследовательских центрах. Наконец, именно комплексы "Эльбрус-2" с 1991 года использовались в системе противоракетной обороны и на других военных объектах.

2-ое направление — дальнейшее развитие на базе БИС и СБИС микро-ЭВМ и персональных ЭВМ (ПЭВМ). Первыми представителями этих машин являются Apple, IBM - PC ( XT , AT , PS /2), «Искра», «Электроника», «Мазовия», «Агат», «ЕС-1840», «ЕС-1841» и др.

Начиная с этого поколения, ЭВМ стали называть компьютерами.

Благодаря появлению и развитию персональных компьютеров (ПК), вычислительная техника становится по-настоящему массовой и общедоступной. Складывается парадоксальная ситуация: несмотря на то, что персональные и миникомпьютеры по-прежнему во всех отношениях отстают от больших машин, львиная доля новшеств - графический пользовательский интерфейс, новые периферийные устройства, глобальные сети - обязаны своим появлением и развитием именно этой "несерьезной" техники. Большие компьютеры и суперкомпьютеры, конечно же, не вымерли и продолжают развиваться. Но теперь они уже не доминируют на компьютерной арене, как это было раньше.

2.5 Пятое поколение

Программа разработки, так называемого, пятого поколения ЭВМ была принята в Японии еще в 1982 году. Предполагалось, что к 1991 году будут созданы принципиально новые компьютеры, ориентированные на решение задач искусственного интеллекта. С помощью языка Пролог и новшеств в конструкции компьютеров планировалось вплотную подойти к решению одной из основных задач этой ветви компьютерной науки - задачи хранения и обработки знаний. Коротко говоря, для компьютеров пятого поколения не пришлось бы писать программ, а достаточно было бы объяснить на "почти естественном" языке, что от них требуется.

Предполагается, что их элементной базой будут служить не СБИС, а созданные на их базе устройства с элементами искусственного интеллекта.

На ЭВМ пятого поколения ставятся совершенно другие задачи, нежели при разработки всех прежних ЭВМ. Если перед разработчиками ЭВМ с 1-го по 4-е поколений стояли такие задачи, как увеличение производительности в области числовых расчётов, достижение большой ёмкости памяти, то основной задачей разработчиков ЭВМ 5-го поколения является создание искусственного интеллекта машины (возможность делать логические выводы из представленных фактов), развитие "интеллектуализации" компьютеров - устранения барьера между человеком и компьютером.

К сожалению, японский проект ЭВМ пятого поколения (рис. 6) повторил трагическую судьбу ранних исследований в области искусственного интеллекта. Проведенные в ходе проекта исследования и накопленный опыт по методам представления знаний и параллельного логического вывода сильно помогли прогрессу в области систем искусственного интеллекта в целом.

Главные направления исследований были следующими:

- технологии логических заключений (inference) для обработки знаний;

- технологии для работы со сверхбольшими базами данных и базами знаний;

- рабочие станции с высокой производительностью;

- компьютерные технологии с распределёнными функциями;

- суперкомпьютеры для научных вычислений.

Рис. 6. Компьютер пятого поколения PIM/m-1

Речь шла о компьютере с параллельными процессорами, работающим с данными, хранящимися в обширной базе данных, а не в файловой системе. При этом, доступ к данным должен был осуществляться с помощью языка логического программирования.

Предполагалось, что прототип машины будет обладать производительностью между 100 млн. и 1 млрд. LIPS, где LIPS — это логическое заключение в секунду. К тому времени типовые рабочие станции были способны на производительность около 100 тысяч LIPS.

Ход разработок представлялся так, что компьютерный интеллект, набирая мощность, начинает изменять сам себя, и окончательной целью было создать такую компьютерную среду, которая сама начнёт производить следующую, причём принципы, на которых будет построен окончательный компьютер, были заранее неизвестны. Эти принципы предстояло выработать в процессе эксплуатации начальных компьютеров.

Далее, для резкого увеличения производительности, предлагалось постепенно заменять программные решения на аппаратные, поэтому не делалось резкого разделения между задачами для программной и аппаратной базы.

Ожидалось добиться существенного прорыва в области решения прикладных задач искусственного интеллекта. В частности, такие как:

- печатная машинка, работающая под диктовку, которая сразу устранила бы проблему ввода иероглифического текста, остро стоящую в то время в Японии;

- автоматический портативный переводчик с языка на язык (непосредственно с голоса), который сразу бы устранил языковый барьер японских предпринимателей на международной арене;

- автоматическое реферирование статей, поиск смысла и категоризацию;

- другие задачи распознавания образов - поиск характерных признаков, дешифровку, анализ дефектов и т. п.

От суперкомпьютеров ожидалось эффективное решение задач массивного моделирования, в первую очередь в аэро- и гидродинамике.

Эту программу предполагалось реализовать за 10 лет, три года для начальных исследований и разработок, четыре года для построения отдельных подсистем, и последние четыре года для завершения всей прототипной системы. В 1982 году правительство Японии решило дополнительно поддержать проект и основало Институт Компьютерной Технологии Нового Поколения (ICOT), объединив для этого инвестиции различных японских компьютерных фирм.

Многие успехи, которые достиг искусственный интеллект, используют в промышленности и деловом мире. Экспертные системы и нейронные сети эффективно используются для задач классификации: фильтрация СПАМа, категоризация текста и т.д.

Добросовестно служат человеку генетические алгоритмы (используются, например, для оптимизации портфелей в инвестиционной деятельности), робототехника (промышленность, производство, быт - везде она приложила свою кибернетическую руку), а также многоагентные системы. Не дремлют и другие направления искусственного интеллекта, например, распределенное представление знаний и решение задач в Интернете: благодаря им в ближайшие несколько лет можно ждать революции в целом ряде областей человеческой деятельности.

Вера в будущее параллельных вычислений была в то время настолько глубокой, что проект «компьютеров пятого поколения» был принят в компьютерном мире очень серьёзно.

После того, как Япония в 70-е годы заняла передовые позиции в бытовой электронике, и в 80-е годы стала выходить в лидеры в автомобильной промышленности, японцы приобрели репутацию непобедимых.

Проекты в области параллельной обработки данных тут же начали разрабатывать в США - в Корпорации по Микроэлектронике и Компьютерной Технологии (MCC), в Великобритании - в фирме Олви (Alvey) и в Европе в рамках Европейской Стратегической Программы Исследований в области Информационных Технологий (ESPRIT).

В СССР также начались исследования параллельных архитектур программирования. Для этого в 1985 году было создано ВНТК СТАРТ, которому за три года удалось создать процессор «Кронос» и прототипный мультипроцессорный компьютер МАРС.

В отличие от японцев, задача интеграции огромного числа процессоров и реализация распределённых баз знаний на базе языков типа Пролог не ставилась, речь шла об архитектуре, поддерживающей язык высокого уровня типа Модула-2 и параллельные вычисления. Поэтому проект нельзя назвать пятым поколением в японской терминологии.

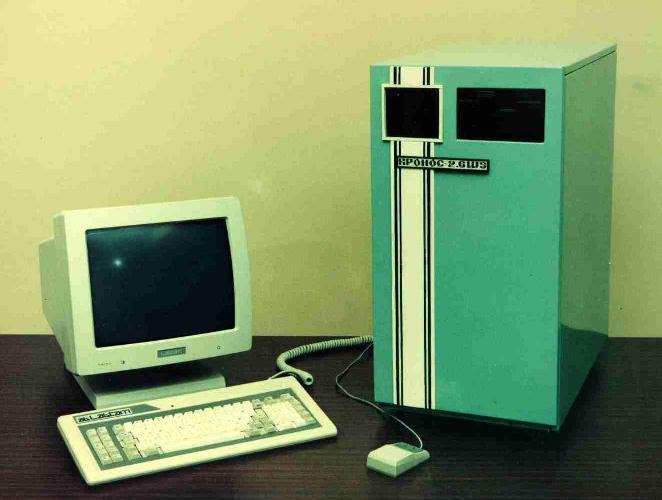

Рис. 7. Рабочая станция Кронос 2.6 WS

В 1988 году проект был успешно завершён, но не был востребован и не получил продолжения по причине «перестройки» и невыгодной для отечественной компьютерной индустрии рыночной ситуации. «Успех» заключался в частичной реализации прототипной архитектуры (в основном, аппаратных средств), однако подобный японскому «большой скачок» в области программирования, баз данных и искусственного интеллекта в рамках этого проекта даже не планировался.

Последующие десять лет японский проект «компьютеров пятого поколения» стал испытывать ряд трудностей разного типа.

Первая проблема заключалась в том, что язык Пролог, выбранный за основу проекта, не поддерживал параллельных вычислений и пришлось разрабатывать собственный язык, способный работать в мультипроцессорной среде. Это оказалось трудным — было предложено несколько языков, каждый из которых обладал собственными ограничениями.

Вторая проблема возникла с производительностью процессоров. Оказалось, что технологии 80-х годов быстро перескочили те барьеры, которые перед началом проекта считались «очевидными» и непреодолимыми, а запараллеливание многих процессоров не вызывало ожидаемого резкого скачка производительности. Получилось так, что рабочие станции, созданные в рамках проекта, успешно достигли и даже превзошли требуемые мощности, но к этому времени появились коммерческие компьютеры, которые были ещё мощнее.

Помимо этого, проект «Компьютеры пятого поколения» оказался ошибочным с точки зрения технологии производства программного обеспечения. Ещё в период разработки этого проекта фирма Apple разработала графический интерфейс (GUI). А позднее появился Интернет, и возникла новая концепция распределения и хранения данных, при этом интернетовские поисковые машины привели к новому качеству хранения и доступа разнородной информации. Надежды на развитие логического программирования, питаемые в проекте «Компьютеры пятого поколения», оказались иллюзорными, преимущественно по причине ограниченности ресурсов и ненадёжности технологий.

Идея саморазвития системы, по которой система сама должна менять свои внутренние правила и параметры, оказалась непродуктивной, т.е. система, переходя через определённую точку, скатывалась в состояние потери надёжности и утраты цельности, резко «глупела» и становилась неадекватной.

Идея широкомасштабной замены программных средств аппаратными оказалась в корне неверной. Развитие компьютерной индустрии пошло по противоположному пути, совершенствуя программные средства на более простые, но стандартных аппаратных. Проект был ограничен категориями мышления 70-х годов и не смог провести чёткого разграничения функций программной и аппаратной части компьютеров.

С любой точки зрения проект можно считать абсолютным провалом. За десять лет на разработки было истрачено более 50 млрд. ¥, и программа завершилась, не достигнув цели. Рабочие станции так и не вышли на рынок, потому, что однопроцессорные системы других фирм превосходили их по параметрам, программные системы так и не заработали, появление Интернета сделало все идеи проекта безнадёжно устаревшими.

Неудачи проекта объясняются сочетанием целого ряда объективных и субъективных факторов:

- ошибочная оценка тенденций развития компьютеров - перспективы развития аппаратных средств были катастрофически недооценены, а перспективы искусственного интеллекта были волюнтаристски переоценены, многие из планируемых задач искусственного интеллекта так и не нашли эффективного коммерческого решения до сих пор, в то время как мощность компьютеров несоизмеримо выросла;

- ошибочная стратегия, связанная с разделением задач, решаемых программно и аппаратно, проявившееся в стремлении к постепенной замене программных средств аппаратными, что привело к излишнему усложнению аппаратных средств;

- отсутствие опыта и глубинного понимания специфики задач искусственного интеллекта с надеждой на то, что авось увеличение производительности и неведомые базовые принципы системы приведут к её самоорганизации;

- трудности, выявившиеся по мере исследования реального ускорения, которое получает система логического программирования при запараллеливании процессоров. Проблема состоит в том, что в многопроцессорной системе резко увеличиваются затраты на коммуникацию между отдельными процессорами, которые практически нивелируют выгоду от параллелизации операций, отчего с какого-то момента добавление новых процессоров почти не улучшает производительности системы;

- ошибочный выбор языков типа Лисп и Пролог для создания базы знаний и манипулирования данными. В 80-е годы эти системы программирования пользовались популярностью для САПР и экспертных систем, однако их эксплуатация показала, что приложения оказываются малонадёжными и плохо отлаживаемыми по сравнению с системами, разработанными обычными технологиями, отчего от этих идей пришлось отказаться. Кроме того, трудность вызвала реализация «параллельного Пролога», которая так и не была успешно решена;

- низкий общий уровень технологии программирования того времени и диалоговых средств (что ярко выявилось в 90-е годы);

- чрезмерная рекламная кампания проекта «национального престижа» в сочетании с волюнтаризмом и некомпетентностью высших должностных лиц, не позволяющая адекватно оценивать состояние проекта в процессе его реализации.

3 Перспективы развития вычислительной техники

Сегодня продолжается дальнейшее развитие архитектур компьютеров. Интенсивные разработки ведутся по многим направлениям. Особенностью этих архитектур является то. что все они основаны не на кремниевых технологиях.

К технологиям, способным экспоненциально увеличивать производительность компьютеров, следует отнести:

— создание молекулярных компьютеров;

— создание биокомпьютеров (нейрокомпьютеров):

— разработку квантовых компьютеров:

— разработку оптических компьютеров.

Рассмотрим основные принципы их построения.

3.1 Молекулярные компьютеры

Молекулярные компьютеры — вычислительные системы, использующие вычислительные возможности молекул (преимущественно органических). В молекулярных компьютерах используется идея вычислительных возможностей расположения атомов в пространстве.

Во многих странах проводятся опыты по синтезу молекул на основе их стереохимического генетического кода, способных менять ориентацию и реагировать на воздействия током, светом и т.п. Ученые фирмы Hewlett-Packard и Калифорнийского университета (UCLA) доказали принципиальную возможность создания молекулярной памяти ЭВМ на основе молекул роксана. Продолжаются работы по созданию логических схем, узлов и блоков. По оценкам ученых, подобный компьютер будет в сотни миллиардов раз экономичнее современных микропроцессоров.

3.2 ДНК-компьютер

ДНК-компьютер — вычислительная система, используюшая вычислительные возможности молекул ДНК (рис. 8). Функционирование ДНК-компьютера сходно с функционированием теоретического устройства, известного в информатике как машина Тьюринга. Особое место принадлежит ДНК-процессорам.

Рис. 8. ДНК-процессор

ДНК-процессоры на уровне отдельных молекул работают очень медленно, но зато с их помощью можно организовывать параллельные вычисления, что дает перспективы по наращиванию производительности. Кроме того, потребляемая мощность таких процессоров очень мала, поэтому очевидны преимущества над полупроводниковыми технологиями.

В 1994 г. Леонард Адлеман, профессор университета Южной Калифорнии (одни из изобретателей криптосистемы RSA), продемонстрировал, что с помощью пробирки с ДНК можно весьма эффектно решать классическую комбинаторную «задачу о коммивояжере» (кратчайший маршрут обхода вершин графа). Классические компьютерные архитектуры требуют множества вычислений с опробованием каждого варианта. Метод ДНК позволяет сразу сгенерировать все возможные варианты решений с помощью известных биохимических реакций. Затем возможно быстро отфильтровать именно ту молекулу-нить, в которой закодирован нужный ответ.

Компьютер Л. Адлемана отыскивал оптимальный маршрут обхода для семи вершин графа. Но чем больше вершин графа, тем больше требуется компьютеру ДНК-матери ала. Было подсчитано, что для решения задачи обхода не 7 пунктов, а около 200, масса количества ДНК, необходимого для представления всех возможных решений, превысит массу нашей планеты.

Ученые Колумбийского университета и университета Нью-Мексико сообщили о создании ДНК-компьютера, способного проводить самую точную и быструю диагностику таких вирусов, как вирус западного Нила, куриного гриппа и т.д. Они представили первую интегральную ДНК-схему со средней степенью интеграции, которая на данный момент является самым быстрым устройством такого типа (Рис. 9).

Рис. 9. ДНК-вентили компьютера MAYA II в пробирках

Изобретению дали название MAYA-П (Molecular Array of YES and AND logic gates), MAYA-II может играть в сложные крестики-нолики. Над ходом он может думать до тридцати минут, но зато никогда не проигрывает. MAYA-I созданный ранее, умеет играть только в простые крестики-нолики.

В 2003 г. сотрудники лаборатории биомолекулярных компьютеров Вейцмановского научного института (Израиль) во главе с профессором Э. Шапиро объявили о создании новой модели биомолекулярной машины, которая не требует наружного источника энергии и работает в 50 раз быстрее, чем ее предшественники. Более ранние системы зависели от молекул АТФ. которые являются главным источником энергии клеточных реакций. В последней модели молекула ДНК обеспечивает и обработку данных, и достаточное количество энергии для выполнения операций. Новый ДНК-компьютер, способный производить 330 трлн вычислительных операций в секунду, был внесен в Книгу рекордов Гиннеса как «самое маленькое биологическое вычислительное устройство, когда-либо построенное человеком».

3.3 Биокомпьютеры или нейрокомпьютеры

Нейрокомпьютеры — это компьютеры, которые состоят из большого числа параллельно работающих простых вычислительных элементов (нейронов). Элементы связаны между собой, образуя нейронную сеть. Они выполняют единообразные вычислительные действия и не требуют внешнего управления. Большое число параллельно работающих вычислительных элементов обеспечивают высокое быстродействие.

Архитектура нейрокомпьютеров иная, чем у обычных вычислительных машин. Микросхемы близки по строению нейронным сетям человеческого мозга. Именно отсюда и пошло название.

Идея создания подобных компьютеров базируется на основе теории перцептрона — искусственной нейронной сети, способной обучаться. Первые перцептроны были способны распознавать некоторые буквы латинского алфавита. Впоследствии модель перцептрона была значительно усовершенствована.

Автором этих идей был американский нейрофизиолог Ф. Розенблат. В 1958 г. он предложил свою модель нейронной сети. Он указал, что структуры, обладающие свойствами мозга и нервной системы, позволяют получить целый ряд преимуществ, а именно:

— более высокую надежность;

— параллельность обработки информационных потоков;

— способность к обучению и настройке;

— способность к автоматической классификации;

— ассоциативность.

Отсюда и особенности нейрокомпьютера. Он способен к обучению, а значит, ему под силу справиться с задачами, которые обычному компьютеру не под силу. Его главная особенность — способность решать задачи без четкого алгоритма или с огромными потоками информации. Поэтому уже сегодня нейрокомпьютеры применяются на финансовых биржах, где помогают предсказывать колебания курса валют и акций. Нейрокомпьютеры, распознавая образы, корректируют полет ракет по заданному маршруту.

3.4 Квантовые компьютеры

Квантовый компьютер — вычислительное устройство, которое путем выполнения квантовых алгоритмов использует при работе квантово-механические эффекты.

Основоположником теории квантовых вычислений считается нобелевский лауреат, один из создателей квантовой электродинамики Ричард Фейнман нз Калифорнийского технологического института. В 1958 г.. моделируя на компьютере квантовые процессы, он понял, что для решения квантовых задач объем памяти классического компьютера совершенно недостаточен.

В основе квантовых вычислений лежит атом — мельчайшая единица вещества. Квантовые вычисления принципиально отличаются от традиционных, так как на атомном уровне в силу вступают законы квантовой физики. Один из них — закон суперпозиции: квант может находиться в двух состояниях одновременно. Обычно бит может иметь значение либо единицу, либо нуль, а квантовый бит (qubit) может быть единицей и нулем одновременно.

Атом — «удобное» хранилище информационных битов: его электроны могут занимать лишь ограниченное число дискретных энергетических уровней. Так, атом высокого энергетического уровня мог бы служить логической единицей, а низкого — логическим нулем. Очевидным недостатком здесь является нестабильность атома, поскольку он легко меняет энергетический уровень в зависимости от внешних условий.

В конце XX в. начали бурно развиваться такие направления науки и техники, как волоконно-оптическая связь, полупроводниковая оптоэлектроника, лазерная техника. Поэтому XXI в. называют веком оптических технологий.

Идея построения оптического компьютера давно интересует исследователей. Многие устройства ЭВМ используют оптику в своем составе: сканеры, дисплеи, лазерные принтеры, оптические диски CD-ROM и DVD-ROM.

Возможности использования света в обработке информации практически безграничны. Если использовать свет для передачи данных между чипами или логическими элементами, не будет существовать проблем со временем задержки на межсоединениях, так как передача информации будет происходить действительно со скоростью света.

Появились и успешно работают оптоволоконные линии связи. Остается создать устройство обработки информации с использованием световых потоков. Способность света параллельно распространяться в пространстве дает возможность создавать параллельные устройства обработки. Это позволило бы на много порядков ускорить быстродействие ЭВМ.

Чтобы использовать уникальные возможности оптики для обработки информации, необходимо разработать подходящие технологии создания устройств генерации, детектирования оптических сигналов, а также оптических логических элементов, управляемых светом. Элементарная оптическая ячейка должна потреблять энергии меньше, чем элемент микрочипа, быть интегрируемой в большие массивы и иметь возможность связи с большим числом подобных элементов.

Заключение

На протяжении всего шестидесяти пяти лет компьютеры превратились из диковинных электронных монстров в мощный, гибкий, удобный и доступный инструмент. Компьютеры стали символом прогресса. По мере того как человеку понадобится обрабатывать все большее количество информации, будут совершенствоваться и средства ее обработки — компьютеры; будут появляться новые языки программирования.

Электронные вычислительные машины, пройдя долгий путь эволюционного развития, используются почти во всех сферах деятельности современного общества. Разнообразие технических характеристик и функциональных особенностей современных ЭВМ позволяет решать с их помощью широкий спектр задач — от бытового применения до управления войсками и оружием. В настоящее время, в эпоху развития наукоемких производств и высоких технологий, экономическая и политическая успешность государства невозможна без создания сбалансированного парка ЭВМ.

Список литературы

- Алексеев А.П. Информатика 2015: учебное пособие/ Алексеев А.П.— 2015. — 400 с.

- Иванов А. А. История развития информатики / А. А. Иванов. - М.: Образ, 2000. – 436 с.

- Информатика. Базовый курс: Учебник для вузов. 3-е изд. Стандарт третьего поколения. — СПб.: Питер, 2011. — 640 с.

- История информатики в России. Ученые и их школы: сб. ст. / Рос. акад. наук; отв. ред. А. С. Алексеев. — М.: Наука. 2003. – 485 с.

- Казакова И. А. История вычислительной техники : учеб. пособие. – Пенза: Изд-во ПГУ, 2011. – 232 с.

- Келим Ю.М. Вычислительная техника : учебник для для студ. учреждений сред. проф. образования / Ю.М.Келим. — 9-е изд., стер. — М.: Издательский центр «Академия», 2014. — 368 с.

- Леонтьев В. П. Большая энциклопедия компьютера и Интернета / В. П. Леонтьев. - М.: ОЛМА Медиа Групп, 2016. – 560 с.

- Петров Ю. П. История и философия науки. Математика, вычислительная техника, информатика / Ю. П. Петров. — СПб.: БХВ-Петербург. 2005. – 444 с.

- Савельев Е. К. Информационная эпоха. / Е. К. Савельев. — СПб.: Питер, 2003. – 368 с.

- Струмпэ Н.В. Аппаратное обеспечение ЭВМ. Практикум: учеб. пособие для нач. проф. образования / Н.В. Струмпэ, В.Д. Сидоров. — 4-е изд., стер. — М.: Издательский центр «Академия», 2014. — 160 с.

- Таненбаум Э. Архитектура компьютера / Э. Таненбаум. — 5-е изд. - СПб.: Питер, 2007. – 826 с.

- Цветков М.С. Информатика и ИКТ: учебник для сред. проф. образования / М.С Цветкока, Л.С. Великович — 6-е изд., стер- М.: Издательский центр «Академия», 2014. - 352 с.

- Разработка регламента выполнения процесса «Учет реализации лекарственных препаратов через аптечную сеть» (Моделирование бизнес-процессов «как есть»)

- «Анализ внешней и внутренней среды организации: SNW-анализ, PEST - анализ»

- Особенности управления и требования к персоналу энергопредприятий

- Построение организационных структур (теоретические аспекты построения организационных структур )

- Человеческий фактор в управлении организацией (Роль человеческого фактора в управлении).

- Налоговые правонарушения (Понятие и состав ответственности за нарушение налогового законодательства РФ)

- Инвестиционная привлекательность предприятия.

- Налоговые правонарушения (Понятие и сущность ответственности за нарушение налогового законодательства)

- Менеджмент человеческих ресурсов (Теоретические основы менеджмента человеческих ресурсов )

- Основы работы с операционной системой «Windows 7»

- Особенности развития европейской валютной системы (Становление и особенности).

- Процессы принятия решений в организации (Природа принятия управленческого решения)