История развития средств вычислительной техники

Содержание:

Введение

История не терпит сослагательных наклонений, но… Каким был бы мир, если бы Наполеон не проиграл в битве при Ватерлоо? Что бы произошло, если бы изобретатель девятнадцатого века Чарльз Бэббидж смог создать первый в мире автоматический компьютер? Ведь у него была правильная идея, но технология его времени не подходила для этой задачи. Альтернативная история -это занимательно, а реальные исторические факты -это отличная возможность найти ответы на важные вопросы. Мы должны учиться у прошлого. Не только историки призывают нас изучать историю. Известна цитата Стива Джобса: «Многие люди не могут похвастаться очень разнообразным опытом. На их жизненном графике не хватает координат, чтобы, соединив их, построить правильную траекторию движения. Большинство не видит проблему во всём её многообразии, поэтому их решения весьма прямолинейны. Чем выше культура человека, позволяющая ему шире использовать опыт человечества, тем лучше его конструкторские решения.»

Из своих успехов и неудач компьютерная индустрия извлекла много важных уроков. Хотя история развития средств вычислительной техники интересна сама по себе, это также позволяет исследовать цепочку событий, которые привели к появлению современных цифровых компьютеров.

В данной работе рассмотрена история развития вычислительной техники от первых механических калькуляторов до их огромных, электромеханических последователей, созданных в начале Второй мировой войны, электронику, которая сделала возможным создание компьютеров, начиная с того, что обычно считается первым успешным электронным компьютером, ENIAC, изобретенного в конце 1940-х годов, а также современные цифровые компьютеры.

Все изученные актуальные аспекты развития вычислительной техники устойчиво обеспечивают новые перспективы в истории технологии.

Цель работы: изучить историю развития средств вычислительной техники

Задачи работы:

- Обобщить и систематизировать источники по данному вопросу

- Выделить наиболее значимые события на каждом этапе развития

- Провести анализ выделенных событий, с точки зрения их влияния на дальнейшие открытия

Глава 1. Первое поколение вычислительной техники

Существуют различные подходы в классификации средств вычислительной техники, но именно выделение поколений по этапам развития, отражает эволюцию с точки зрения используемой элементной базы и архитектуры. Основные поколения и их краткие характеристики приведены в таблице 1.

Таблица 1. Этапы развития средств вычислительной техники

|

Поколение |

Временной промежуток |

Действие основано на работе |

|

1 поколение |

40- 50-е годы XX века |

Электронных ламп |

|

2 поколение |

50- 60-е годы XX века |

Дискретных полупроводниковых приборов (транзисторов) |

|

3 поколение |

60- 80-е годы XX века |

Полупроводниковых интегральных схем |

|

4 поколение |

80-90-е годы- XX века |

Больших и сверхбольших интегральных схем |

|

5 поколение |

После 90-х годов XX века |

Микропроцессора |

Первая эра вычислительной техники приходится на 1945-1954 гг XX века. Основными характеристиками вычислительных машин этого периода является:

- Отсутствие операционной системы

- Программы создавались на машинном языке

- Использовались подключаемые платы для управления компьютером.

- Пользователь компьютера должен сидеть за консолью.

- Отсутствие промежутков между вычислениями, вводом-выводом, временем выполнения и временем отклика.

- Программы, загружаемые вручную через карточные колоды.

- Основной целью являлась создание таблиц чисел.

- Компьютеры были экзотическим экспериментальным оборудованием

При этом можно выделить прогресс, который отчетливо выражен по сравнению с предыдущим периодом:

- Люди создали библиотеки, которыми они могли бы поделиться с другими.

- Эти библиотеки были предшественниками современных операционных систем.

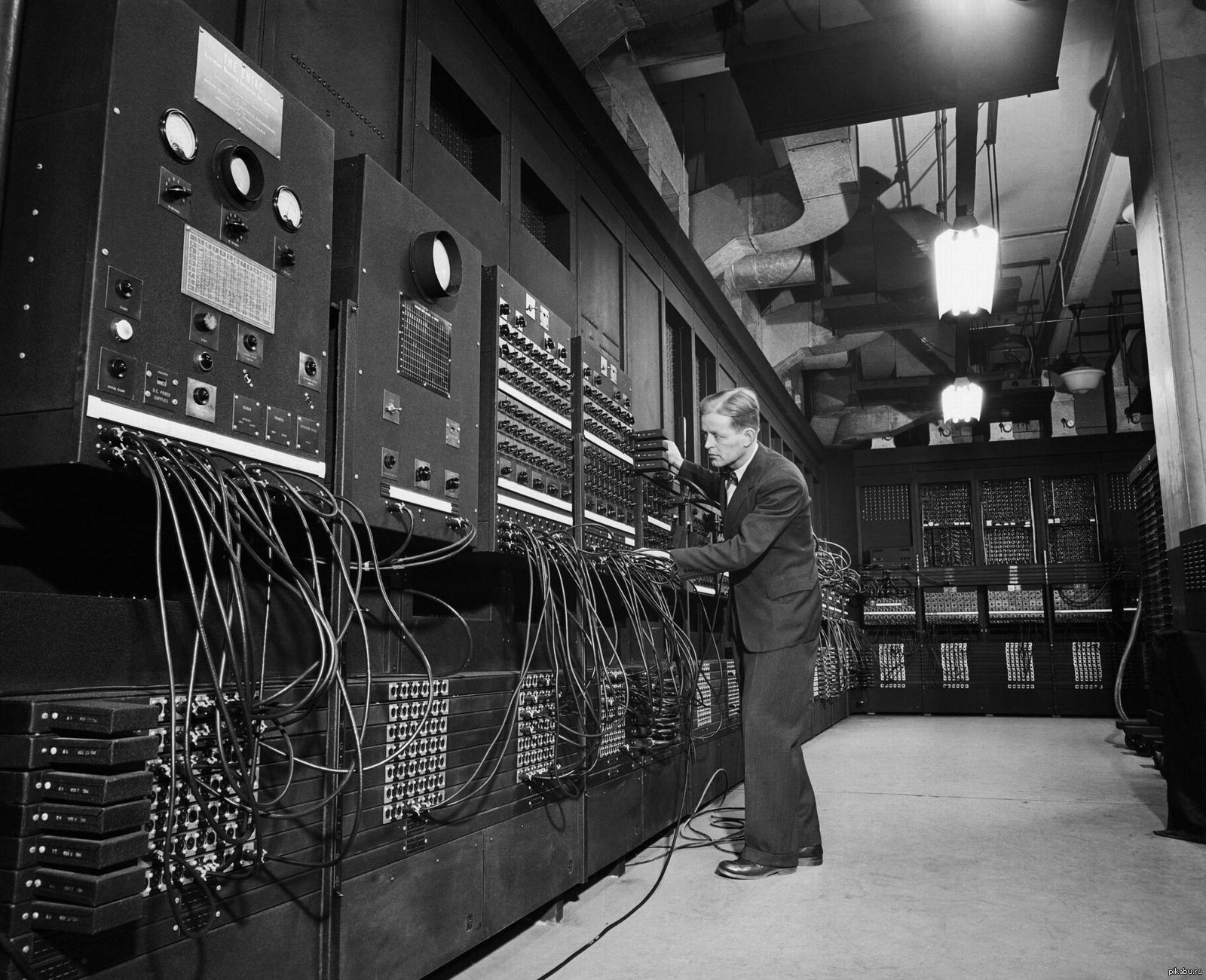

Рассмотрим первое поколение вычислительных машин более подробно. Первая универсальная работоспособная электронная вычислительная машина была названа ENIAC (рис 1.)

Ее создали Преспер Эккерт и Джон Мокли в школе Мура университета Пенсильвания. Название — машины- это аббревиатура, которая дословно переводится как, электронный числовой интегратор и калькулятор. Финансировался данный проект армией США и активно действовал во время Второй мировой войны, но до 1946 года так не был обнародован. ENIAC использовался для вычисления таблиц стрельбы артиллерии. Машина была огромной-100 футов длиной, 8,5 футов высокий и несколько футов шириной. Каждый из 20 десятизначных регистров был 2 фута длиной. В ее составе насчитывалось 18 000 вакуумных ламп.

Хотя размер был на три порядка больше, чем размер средней современной машины, Интегратор и Калькулятор был более чем на пять порядков медленнее. При этом необходимо отметить, что ENIAC, был программируемым, что четко отличало его от более ранних калькуляторов.

Программирование выполнялось вручную. Для этого необходимо было затыкать вверх кабели и устанавливать переключатели, что требовало от получаса до целого дня. Данные представлялись в виде перфорационных карт. ENIAC был ограничен главным образом небольшим количеством хранения и отличался очень сложным и монотонным процессом программирования.

Рис. 1. ENIAC, созданная Джон Преспер Эккерт и Джон Уильям Мокли

В 1944 году Джон фон Нейман был привлечен к проекту ENIAC. Он создал группу по улучшению способа ввода программ. При этом активно обсуждался вопрос хранения программ в числовом виде. Джон фон Нейман помог обобщить и систематизировать идеи и написал работу, предлагающую компьютер с сохраненной программой под названием EDVAC. Герман Гольдстайн растиражировал эту работу и поставил на ней имя фон Неймана, к большому разочарованию Эккерта и Мокли, чьи имена среди авторов не были указаны. Эта работа послужила основой для широко используемого термина «Компьютер фон Неймана». Ряд историков-исследователей в компьютерных областях полагают, что это термин дает слишком много кредитов фон Нейману, который концептуализировал и записал идеи, и слишком мало для инженеров Эккерта и Мокли, которые непосредственно работали над созданием машины. Но большинство историков, все же считают, что все эти три человека сыграли ключевую роль в развитии вычислительной техники. Роль фон Неймана в написании идей, в их обобщении и в осмыслении программных аспектов имела решающее значение для передачи идей более широкой аудитории.

В 1946 году Морис Уилкс из Кембриджского университета посетил школу Мура побывав на последней части цикла лекций о разработках в области электронных вычислительных машин. Когда он вернулся в Кембридж, Уилкс решил начать проект построение компьютера с сохраненной программой под названием EDSAC ( Автоматический Калькулятор). EDSAC использовал ртутные линии задержки для своей памяти, отсюда и словосочетание "задержка хранения" в его названии. EDSAC начал функционировать в 1949 году. Эта дата считается важным этапом развития вычислительной техники, дата, когда был создан первый в мире полномасштабный оперативный компьютер с сохраненной программой.

Его небольшой прототип называется Марк I. Он был построен в Университете Манчестера и начал свою работу в 1948 году, может называться первой оперативной машиной с сохраненной программой. Архитектура EDSAC была основана на работе аккумулятора. Этот стиль архитектуры набора инструкций оставался популярным до начала 1970-х.

В 1947 году Мокли нашел время, чтобы помочь основать новую компьютерную ассоциацию ACM. Он был первым вице-президентом и вторым президентом ACM.

В том же году Экерт и Мокли подали заявку на патент на электронные компьютеры. Декан Школы Мура, требуя, чтобы патент был передан университету, возможно, подтолкнули Эккерту и Мокли к выводу о том, что они должны уйти со своих должностей.

Их уход стал концом для проекта EDVAC, который закрылся до 1952 года. Гольдстайн уехал, чтобы присоединиться к фон Нейману в Институте перспективных исследований Принстоне, в 1946 году. И вместе с Артуром Берксом они опубликовали отчет, основанный на «Burks, Goldstine, and von Neumann» (1946 г.).

Это послужило тому, что в Принстонском институте перспективных исследований Джулианом Бигелоу создал свою машину IAS.

Она имела в общей сложности 1024 40-битных слов и был примерно в 10 раз быстрее, чем ENIAC. Группа единомышленников Джулиана Бигелоу подумала об использовании машины, опубликовала ряд отчетов и призвала посетителей. Эти отчеты и посетители вдохновили на разработку ряда новых компьютеров, включая первый компьютер IBM, 701, который был основан на

машине IAS. Статья Беркса, Голдстайна и фон Неймана произвела фурор, она была невероятной для того времени. Читая его сегодня, вы никогда не догадаетесь, что это документ был написан в середине прошлого века. Ведь большинство рассмотренных там архитектурных концепций используются в современном компьютере.

В то же время, что и ENIAC, Говард Эйкен разрабатывал электромеханический компьютер под названием Mark-I в Гарварде. Он был разработан командой инженеров из IBM. За Mark-I с релейной машиной, создан был Mark-II с парой вакуумных трубок, далее Марк-III и Марк-IV.

Марк-III и Mark-IV были построены после первых машин с сохраненной программой. Потому что они имели отдельные памяти для инструкций и данных, машины были считаются первыми компьютерами с сохраненными программами. Каждый из них оперировал 72 числами, состоящими из 23 десятичных разрядов, делая по 3 операции сложения или вычитания в секунду. Умножение выполнялось в течение 6 секунд, деление — 15,3 секунды, на операции вычисления логарифмов и выполнение тригонометрических функций требовалось больше минуты.

Фактически «Марк I» представлял собой усовершенствованный арифмометр, заменявший труд примерно 20 операторов с обычными ручными устройствами, однако из-за наличия возможности программирования некоторые исследователи называют его первым реально работавшим компьютером.

Термин Гарвардская архитектура была придумана, чтобы описать этот тип машины. Хотя, естественно, далекий от первоначального замысла, этот термин используется сегодня для того чтобы примениться к машинам с одиночной основной памятью, но с отдельными кэшами команд и данных.

Проект «Whirlwind» стартовал в Массачусетском технологическом институте в 1947 г. Он был нацелен на применение в режиме реального времени обработки радиолокационных сигналов. Впоследствии, это сделало возможным несколько открытий, каждое из которых базировалось на создании магнитного сердечника. Ставшая впоследствии первой надежной и недорогой технологией памяти.

«Whirlwind» имел 2048 16-битных слов магнитного сердечника. Магнитные сердечники служили в качестве основной памяти для компьютерной технологии еще почти 30 лет.

Во время Второй мировой войны основные вычислительные усилия как в Великобритании, так и в США сосредоточились на специальных компьютерах, взламывающих коды. Работа Британии была нацелена на расшифровку сообщений, закодированных с помощью немецкого шифра Enigma.

Эта работа по расшифровке, велась в городе Блетчли-Парк. Она стала залогом создания двух важных вычислительных машин.

Первая, электромеханическая машина, задуманная Аланом Тьюринга, названа «BOMBE», а вторая, гораздо большая электронная машина, задуманная и разработанная Ньюманом «COLOSSUS». Это были узкоспециализированные криптоаналитические машины, которые играли жизненно важную роль в войне, предоставляя возможность читать зашифрованные сообщения. Работа в Блетчли-парке была строго засекречена, поэтому её непосредственное влияние на развитие ENIAC, EDSAC и другие компьютеры трудно отследить, но она, безусловно, оказала косвенное влияние на продвижение технологии и получение понимания проблем.

Аналогичная работа над специализированными компьютерами для криптоанализа продолжалась и в США. Непосредственным последователем этих усилий была компания «Engineering Research Associates» («ERA»), которая была основана после войны. Основной идеей ее являлось получение большой прибыли.

«ERA» построила несколько машин, которые были проданы секретным правительственным учреждениям, в том числе Сперри-Ранду, который незадолго до этого приобрел компьютерную корпорацию Джона Преспера Экертом и Джона Уильяма Мокли.

Другим направлением создания вычислительных машин, который оказал влияние на ход событий, была группа машин специального назначения, построенных Конрадом. Их называли «Zuse», они были разработаны в Германии в конце 1930 - х и начале1940-х.

Именно машина «Zuse» впервые использовала запись числа с плавающей точкой. Фон Нейман узнав, о таком предложении, утверждал, что эта идея не имеет будущего. Его последняя машина была электромеханической, но, из-за войны, она так никогда и не была завершена.

Большое вклад в развитие вычислительной техники принадлежит Джону Атанасову, который построил мелкомасштабный электронный компьютер в начале 1940-х. Его машина, разработанная в Университете штата Айова, была специального назначения. Компьютер назвали ABC, что переводилось как, компьютер Атанасова Берри. К большому сожалению, он никогда не был полностью работоспособным. Экерт и Мокли посещал Атанасова, накануне создания ENIAC и позаимствовали некоторые из идей, например, использование двоичного представления чисел. Наличие машины Атанасова, задержало подачу патентов ENIAC, .т.к. работа была засекречена, и патенты не могли быть поданы до окончания войны. Публикации о EDVAC фон Неймана были использованы для того чтобы сломать «Eckert» –Патент Мокли. Хотя споры по-прежнему бушуют вокруг Атанасова и его роли в разработке и влиянии на Джона Преспера Экертом и Джоном Уильямом Мокли, именно Джона А. считают создателем первой универсальная электронной вычислительной машины. Именно он смог продемонстрировать несколько важных инноваций, включенных в более поздние компьютеры. Вклад Джона Атанасова в развитие вычислительной техники огромен.

Глава 2. Второе поколение компьютеров

Основной особенностью вычислительной техники второго поколения является использование транзисторов вместо электронных ламп, и широкое применение магнитных сердечников и барабанов в качестве устройств памяти. Следует отметить так же следующие тенденции этого периода:

- Создание компьютеров было очень дорогостоящим, людская рабочая сила намного дешевле;

- Более эффективное использование компьютера: перемещение человека подальше от машины.

- Появление первых прототипов операционных систем.

- Компьютер работает пакетами программ. Сначала загружается задание, происходит его запуск, а затем переход к следующему шагу. Если программа не удалась, содержимое памяти записывается и сохраняется.

- Использование оборудования стало более эффективным, но трудности при отладке программы увеличиваются.

Технологии этого периода отличаются тем, что:

- Используются каналы данных и прерывания

- Буферизация и обработка прерываний осуществляются ОС

- Катушка выполняет задания на более «высокой скорости», чем магнитные карты

- Большое количество возникающих трудностей

- Низкая продуктивность, компьютер может выполнять лишь одно задание за раз.

- Отсутствие защиты между различными работами.

- Выполнение даже коротких заданий занимает много времени, если, им предшествует более длинные задания.

- Модернизация оборудования, появляется защита памяти и перемещение в другое место

- Мультипрограммирование: многие пользователи могут совместно использовать систему.

- Возможность планирования: приоритет принадлежит окончанию малых задач.

- Первая ОС была представлена в 1963 году, а начала работать в 1968 году. ОС управляет взаимодействием между параллельными процессами.

- Разработана первая операционная система (ОС), предназначенная для семейства компьютеров;

- Разработка ОС были чрезвычайно сложный процесс.

- ОС были написаны на ассемблере.

- Отсутствие структурированного программирования.

Рассмотри подробнее второй этап развития вычислительной техники.

В декабре 1947 года Экерт и Мокли создали корпорацию «Eckert-Mauchly Computer». Их первая машина, BINAC, была построена для Northrop и продемонстрирована в августе 1949 года. После некоторых финансовых трудностей компьютерная корпорация Эккерта-Мокли была приобретена «Remington-Rand», позже названной «Sperry-Rand». Сперри-Рэнд смогла начать работу по созданию специализированного компьютерного подразделения под названием UNIVAC. UNIVAC поставила свой первый компьютер, UNIVAC I, в июне 1951 года. В последствии он был продан за $250 000 и был первым успешным коммерческим компьютером. Сегодня, эту раннюю модель, наряду со многими другими увлекательными компьютерными экспонатами, можно увидеть в Музее компьютерной истории в Маунтин-Вью, Калифорния. Выставки ранних вычислительных систем, находятся так же в Немецком музее в Мюнхене и Смитсоновском институте Вашингтона, Округ Колумбия, а также в многочисленных виртуальных онлайн-музеях.

IBM, которая ранее была в бизнесе перфокарты и автоматизации делопроизводства, не начинали строить компьютеры вплоть до 1950 года. Первый компьютер IBM –IBM 701, основанный на машине ИАС фон Неймана, был собран в 1952 году. Таких компьютеров было продано 19 единиц.

В начале 1950-х годов, многие люди пессимистично относились к будущему компьютеров, считая, что сфера использования и возможности этих "узкоспециализированных" машин были весьма ограничены. Тем не менее IBM быстро стала самой успешной компьютерной компанией.

Они сделали ставку на надежность и клиентоориентированность ,что в условиях рыночных отношений стало определяющими. Хотя IBM 701 и IBM 702 имели скромные успехи, последующие машины IBM 650, 704, и 705 (разработанные в 1954 и 1955 гг.) имели значительный успех. Каждый из них был продан в количестве от 132 до 1800 компьютеров.

На заре вычислительной техники, создатели ENIAC поставили перед собой цель достичь высоких показателей в производительности компьютера: быть в 1000 раз быстрее, чем Harvard Mark-I, а IBM Stretch (7030) должен был быть в 100 раз быстрее, чем самая быстрая машина в мире. Один лишь вопрос оставался открытым, как эту производительность измерить. Оглядываясь назад, можно утверждать, что каждое следующее поколение компьютеров и его методы оценки эффективности, очень быстро устаревает для последующих поколений.

Первоначально за показатель производительности принимали время выполнения отдельной операции, например, сложения. Поскольку для большинства моделей эта операция занимала одинаковое время выполнения, возникла необходимость в другом показателе. Перечень операций в моделях вычислительной техники постоянно увеличивался, а значит сравнение времени их выполнения становилось бесполезным. Чтобы учесть все различия, возникла идея расчёта измерения относительной частоты команд в компьютере. До появления общепринятых тестов производительности усреднённые оценки быстродействия компьютеров вычислялись на основе смеси инструкций. Наиболее известной является смесь Гибсона, полученная Джеком Гибсоном из корпорации IBM для научных программ. Для коммерческих программ были разработаны смеси, не включающие операции с плавающей запятой, например, смесь ADP. Умножение времени для каждой инструкции на ее вес дает пользователю среднее время выполнения команды. Поскольку наборы инструкций были похожи, это было самое точное сравнение.

Поскольку процессоры стали более сложными, активно использовалась иерархия памяти и буферезация. Таким образом, появились все условия для возникновения MIPS - набора команд и инструкций

Следующим шагом стало проведение бенчмаркинга для использования ядер и кристаллов при выполнении задач. В 1976 г. H. J. Curnow, Brian A. Wichmann. создали программу, которая написана с помощью языка программирования Алгол 60. Позднее он был преобразован в FORTRAN и широко использовался. В том же направлении в 1986 году с ядром компьютера работали исследователи Лаборатории Лоуренса Ливермора. Основной их задачей было установить эталон для суперкомпьютеров.

Как выяснилось, с помощью MIPS можно сравнивать архитектуры с разными наборами команд. Появилось понятие относительных MIPS. Когда VAX-11/780 был готов к анонсу в 1977 году, DEC запускал небольшие тесты

на IBM 370/158. Компании IBM по маркетингу называют 370/158 качестве 1 MIPS компьютер, и, поскольку программы работали с той же скоростью, DEC marketing назвал VAX-11/780 A 1 MIPS компьютер. Рейтинг 1 MIPS не подвергался сомнению в течение 4 лет, пока Джоэл Эмер из DEC измерил VAX-11/780 под нагрузкой с разделением времени. К началу 1980-х годов термин MIPS почти повсеместно используется для обозначения относительных MIPS.[1,3,6]

Глава 3. Третье поколение вычислительной техники

В третьем поколении вычислительной техники впервые стали использоваться интегральные схемы – целые устройства и узлы из десятков и сотен транзисторов, выполненные на одном кристалле полупроводника. Этот период приходится на 1970-1980 г.г. В это время:

- Компьютеры и люди, умеющие с ними работать, стоят дорого

- Компьютерная помощь человеку становится более продуктивной.

- Интерактивный обмен временем: многие пользователи могут использовать одну и ту же машину одновременно.

- Активное использование терминалов (например, система авиакомпании)

- Желание пользователей держать данные в режиме онлайн, используя при этом разнообразные файловые системы.

- Попытки обеспечить разумное время на ответ, полученный с помощью компьютера.

- Предусмотрен один главный компьютер для поддержки “всех".

- Люди начинают покупать компьютеры

- Появляются понятия иерархическая файловая система, устройства, файлы

- Новая идея: появление новой портативной операционной системы

- Университеты получили программный код для экспериментов с компьютерами.

- Berkeley добавил поддержку виртуальной памяти для VAX.

- DARPA выбрало UNIX в качестве своей сетевой платформы (arpanet).

- UNIX становится коммерческой операционной системой.

- Внедряются важные идеи для популяризированные UNIX

- ОС написана на языке высокого уровня.

1970-е и 1980-е годы ознаменовали рост суперкомпьютерной промышленности, которая определялась высокой производительностью для программ, использующих запись чисел с плавающей запятой. Понятие среднего времени выполнения и MIPS стали явно неуместными показателями для компьютеров этого времени. Возникла потребность в новых интегументах измерения быстродействия компьютера. Им стал MFLOPS- внесистемная единица, используемая для измерения производительности компьютеров, показывающая сколько операций с плавающей запятой в секунду выполняет данная вычислительная система. Основной тенденцией этого периода является, то компьютеры стали покупаться обыкновенными людьми, маркетинговые группы вели войны в погоне за новым клиентом и для увеличения рейтинга гнались за пиковыми MFLOPS в войне суперкомпьютерной производительности. Так появилась SPEC- организация, главной целью которой было представление и оценка компьютерных систем. Она была основано в конце 1980-х годов, чтобы попытаться улучшить состояние компьютерной отрасли и разработать более обоснованную систему тестов для сравнения. Первоначально группа сосредоточилась на рабочих станциях и серверах Unix marketplace. Они остаются в центре внимания SPEC сегодня.

Первый выпуск спецификаций критериев, который называется SPEC89, стал существенным улучшением использования более реалистичных контрольных показателей. Аналогичными способами тестируются компьютеры и сегодня почти тестирует почти четыре десятилетия спустя.

В конце 1970-х и начале 1980-х годов люди поняли, что стоимость программного обеспечения растет быстрее, чем затраты на оборудование. В 1967 году Маккиман У. своей книге «Генератор компиляторов» писал о том, что компиляторы и операционные системы стали слишком большими и сложными, и на их разработку уходит слишком много времени.

Из-за плохих компиляторов и ограничений памяти компьютеров, большинство системных программ, в то время, еще писались на ассемблере. Много

исследователей в попытке смягчить кризис программного обеспечения, пытались разработать более мощные, программно-ориентированные архитектуры. В 1977 году Эндрю Таненбаум стал изучать свойства языка высокого уровня. Как и другие исследователи, он обнаружил, что большинство программ, написанные с помощью этого языка, сравнительно просты. Он утверждал, что архитектуры должны быть разработаны с учетом этого и что их следует оптимизировать для уменьшения размеров программы и простоты компиляции. Э. Таненбаум предложил стековый компьютер c частотно-кодированными форматами команд для их выполнения, однако, размер программы напрямую не воздействовал на затраты производительности, и стек компьютеров исчез вскоре после своего возникновения.

В 1978 году активно обсуждался вопрос разработки других архитектур. Так в DEC создали VAX- Virtual Address eXtension. Новая 32-битная архитектура была разработана, чтобы упростить компиляцию языков высокого уровня. VAX была конструирована для того, чтобы оптимизировать размер кода, ведь скомпилированные программы были часто слишком большими для запоминания. VAX-11/780 был первым компьютером, анонсированным в серии VAX. Это один из самых успешных и наиболее изученных когда-либо созданных компьютеров.

Краеугольным камнем стратегии DEC была единая архитектура VAX, работающая под управлением единой операционной системы VMS. Эта стратегия хорошо работала более 10 лет. Большое количество документов, позволяющих использовать его для различных операционных систем, измерения, реализации и анализ сделали VAX его идеальным решением того времени.

Глава 4. Четвертое поколение вычислительной техники

Период 1980-1990гг. принадлежит компьютерам четвертого поколения. Прогресс этой сферы идет, в основном, по пути развития того, что уже изобретено и придумано, – прежде всего за счет повышения мощности и миниатюризации элементной базы и самих компьютеров. С начала 80-х, благодаря появлению персональных компьютеров, вычислительная техника становится по-настоящему массовой и общедоступной. Этот этап можно охарактеризовать следующими тенденциями:

- Компьютеры становятся более дешевыми, а знания профессионалов, умеющих с ними работать, более дорогими.

- Вычислительная техника была помещена в каждый терминал

- Разработана первая операционная система персонального компьютера.

- IBM требовалось программное обеспечение для своих ПК

- Гейтс обратился в Seattle Computer Products, купил 86-DOS, и на его основе создал MS-DOS.

- ОС имеет вид библиотеки подпрограмм и исполнителей команд.

- Появляются персональные рабочие станции

- Появляются персональные компьютеры

- Создание Apple II

- Создание IBM PC

- Увеличение пользователей Macintosh

- Бизнес-приложения продвигают отрасль

- Разработка и внедрение текстовых процессоров

- Разработка и внедрение электронных таблиц

- Разработка и внедрение баз данных

- Выпуск большого количества компьютерных приложений

В 1991 году Ричард А. Бруннер и Дилип П. Бхандаркар в совей книге «Справочное руководство по архитектуре VAX» дали количественный анализ недостатков VAX по сравнению с компьютером RISC, по существу положив начало технической кончина VAXа.

Первым суперкомпьютером, построенным на транзисторах считается Stretch, IBM 7030. Stretch следовал за IBM 704 и имел цель быть в 100 раз быстрее, чем он. Цель была достигнута. План состоял в том, чтобы получить коэффициент 1,6 от перекрывающейся выборки, процесса декодирования и выполнения, используя четырехступенчатый конвейер. Многие решения, которые были применения были описаны еще в начале 60-х годов Вернером Бухольцем. Именно он ввел термин «байт» и описал конструкторские и инженерные компромиссы, в том числе с использованием обходов ALU.

Первые процессоры RISC были созданы ее в 1964 году. Именно в 80-х годах они получили свое широкое распространение. Несколько ранних работ по изучению RISC, опубликованных в начале 1980-е годы, стали попыткой количественной оценки преимуществ упрощения набор инструкций. Однако лучшим анализом сравнения VAX и MIPS является публикация Дилип П. Бхандаркар в 1991 году, через 10 лет после первого опубликованные документа о RISC. После 10 лет споров о преимуществах внедрения RISC, эта статья убедила даже самых отчаянных скептиков-конструкторов о преимуществах архитектуры набора инструкций RISC.

Несколько исследовательских проектов ввели параллельные разработки, связанные с многозадачностью компьютера. Так в середине 1980-х, процессор Stanford MIPS имел возможность разместить два операции в одной инструкции, хотя эта возможность была снижена в коммерческих вариантах архитектуры, в первую очередь по соображениям производительности. В это же время в Йельском университете профессор Джозеф Фишер со своими коллегами предложил создать процессор с очень широкой инструкцией (512 бит) и назвала этот тип процессора VLIW. VLIW - это обычные компьютеры, предназначенные для запуска скомпилированного кода и используемые как обычные компьютеры, но предлагающие большие объемы параллелизма на уровне команд, запланированные планировщиком трассировки или подобным компилятором. VLIW сейчас широко используются, особенно во встроенных системах. Самые популярные ядра VLIW были проданы в количестве нескольких миллиардов процессоров. Использованный для этого код был сгенерирован для процессора с помощью планирования трассировки и первоначально разрабатывался Фишером для генерации микрокода. Реализация планирования трассировки для Йельского процессора описана Джозефом Фишером в 1984 году. [10]

IBM отменила ACS и активные исследования в этой области в 1980-е годы. Более чем через 10 лет после того, как ACS был отменен, Джон Кок сделал новое предложение для суперскалярного процессора, динамически принимающего решение. Джон Кок и Тилак Агервала описал ключевые идеи в нескольких выступлениях в середине 1980-х годов и придумал термин суперскаляр.

В 1984 году Ж. Э. Смит и его коллеги в Висконсине предложили подход, который решал несколько проблем с ограниченным динамическим планированием процессора. Его ключевой особенностью является использование очередей для поддержания порядка между классами инструкций, например, ссылок на память, позволяя ему пропускать вперед еще один класс инструкций. Трансивер ZS-1, описанный Ж. Э. Смит оплощает этот подход с очередями для подключения блока хранения нагрузки и операционных блоков. Реализация Power2 использует очереди аналогичным образом. В 1989 году Э. Смит описал преимущества динамического планирования и сравнили его с подходом к статическому планированию.

IBM System/360 Model 91 — модель серии компьютеров IBM System/360 компании IBM. Была объявлена в 1964 году как конкурент суперкомпьютеру CDC 6600 компании Control Data Corporation. Модель 91 была самой производительной в линейке IBM S/360 и предназначалась для научных вычислений и использовалась для исследования космоса, в физике элементарных частиц и численного прогноза погоды. Модель 91 была первым компьютером IBM, поддерживающим внеочередное исполнение инструкций. В компьютере были реализованы многие новшества для использования параллелизма на уровне команд: конвейеризация исполнительных устройств, переименование регистров, предсказание переходов, динамическое обнаружение конфликтов памяти. В модуле вещественной арифметики был впервые реализован Алгоритм Томасуло, который он описал в 1967 году. Этот алгоритм использовал переименование регистров для внеочередного исполнения инструкций. Многие эти идеи на 25 лет практически были забыты, пока их не стали активно использовать в микропроцессорах в 1990-х годах[3,5].

В 1988 году Д. Смит и А. Плесцкун исследовали использование буферизации и ведение точных прерываний, в результате ими была описана концепция буфера переупорядочения. А в 1990 г. было описано добавление переименования и динамического планирования, открыв тем самым новые возможности для развития этого направления.

Нэнси Патт-американский профессор электротехники и вычислительной техники в Техасском университете в Остине и его коллеги были ранними сторонниками агрессивного переупорядочения. Они сосредоточились на контрольно-пропускном пункте и механизмах перезапуска. Впервые реализованный ими подход в HPSm, который также является расширение алгоритма Томасуло.

Параллельно с суперскалярными разработками, рос коммерческий интерес к VLIW. Многопоточный процессор был основан на концепциях, разработанных в Йельском университете, хотя многие важные уточнения для повышения практичности подхода были сделаны уже позднее. Среди них был буфер хранилища с контрольной меткой.

Хотя было продано более 100 многопоточных процессоров, различные проблемы, в том числе трудности внедрения нового набора инструкций от небольшой компании, конкуренция со стороны коммерческих RISC микропроцессоров, не смогли изменить экономику на рынке мини-компьютеров привели к провалу компании.

Почти одновременно с запуском компьютерных компаний Multiflow, Cydrome было начато создания процессора VLIW, который также оказался неудачным коммерчески.

В 1989 году Dehnert, Hsu и Bratt объяснили архитектуру и производительность Cydrome Cydra 5, процессора с широким набором инструкции, обеспечивающим динамическую регистрацию переименования и дополнительную поддержку конвейерной обработки программного обеспечения. Cydra 5, являлся уникальным сочетанием аппаратного и программного обеспечения, включая условные регистры вращения, направленный на извлечение ILP. Cydrome полагался на большие ресурсы, чем в многопоточном процессоре и смог добиться конкурентоспособности в первую очередь на коды. Но большое количество проблем в Cydrome привели к отсутствию коммерческого успеха в разработке. И Это не смтря на то, что при своей стоимотси в почти 1 млн. компьютер мог достигать трети производительности компьютера за 10-2- млн. $. [7,9,12]

И Multiflow, и Cydrome хотя и были неудачными коммерческими структурами, произвели много профессионалов с большим опыт в разработке ILP-параллелизма на уровне инструкций, а также передовых технологий компиляторов. Многие из этих людей пошли дальше, чтобы включить свой опыт и фрагменты разработанных технологии в более новые процессоры.

В 1993 году был издан обширный сборник статей, охватывающий описание аппаратного и программного обеспечения всех важных процессоров. В нем так же был описан метод планирования, называемый полициклическим планированием, что в дальнейшем стало основой для большинства программно-конвейерных схем.

В начале 1990-х годов Вэнь-Мэй Хву и его коллеги из Университета Иллинойса разработали компилятор под названием IMPACT, для изучения взаимодействия между архитектурой с различными выпусками и технологией компилирования. Этот проект привел к нескольким важным идеям, включая суперблок планирования, широкое использование профилирования для руководства различными оптимизациями и использование специального буфера, аналогичного к ALAT или программно-управляемого буферного хранилища, для составления автоматизированного обнаружения конфликтов памяти. Был исследован компромисс между производительностью частичной и полной поддержкой предикации.

Все ранние процессоры RISC имели отложенные ветви, схемы, а внедрение микропрограммирования и нескольких исследований по прогнозированию ветвей времени, позволили усовершенствовать механизм компиляции. В 1986 году это удалось Уэйн Роберт Хеннесси и его команде. Они сделали количественное сравнение различных схем модуля предсказания переходов или прогнозирования ветвления, а также времени компиляции и времени выполнения.

В 1992 году была сделана оценка этой работе, в которой отмечался о диапазон компиляции временной ветви-схемы прогнозирования с использованием метрики расстояния между ошибочными предсказаниями.

Глава 5. Пятое поколение вычислительной техники

Переход к компьютерам пятого поколения предполагал переход к новым архитектурам, ориентированным на создание искусственного интеллекта, создание развитого человеко-машинного интерфейса (распознавание речи, образов). Это все относится к классу суперкомпьютеров. Это компьютеры, которые имеют максимальную на время их выпуска производительность, или так называемые компьютеры 5-го поколения. К основным характеристикам и нововведениям этого периода можно отнести:

- Подключение имеет первостепенное значение.

- Люди хотят обмениваться данными, а не аппаратными средствами.

- Сетевые приложения продвигают отрасль.

- Большие запросы на развитие компьютерных сетей

- Развитие электронной почты

- Защита и мультипрограммирование менее важны для персональных машин.

- Защита и мультипрограммирование более важны для серверных машин.

- Рынок компьютерных услуг продолжает горизонтальное расслоение

- Появляются Интернет-провайдера, предоставляющие услуги-посредника между ОС и приложениями

- Информация становится товаром

- Реклама становится компьютерным рынком.

- Возникают новые сетевые архитектур

- Развиваются распределенные операционные системы

- Возникает понятие «Облако»

Блестящие результаты на этом этапе стали возможны благодаря ранним попыткам построить LOW и VLIW машины-особенно компаниями Cydrome и Multiflow. В долгой истории работы компилятора, которые продолжались университете Иллинойса и других местах даже после того, как эти компании потерпели неудачу в HP. Идеи, полученные в результате этой работы, привели разработчиков HP к предложению 64-разрядную архитектуру VLIW в соответствии с архитектурой HP PA RISC.

Intel искала новую архитектуру для замены x86 (теперь называется IA-32) архитектуры и обеспечить 64-разрядную возможность. В 1995 году они сформировали партнерство для разработки новой архитектуры IA-64 и начали строить процессоры на его основе. Itanium является первым таким процессором.

В 2002 году Intel представила дизайн второго поколения IA-64, Itanium 2.

Еще один подход, который исследован в литературе, - это использование прогнозирования стоимости. Предсказание этих значений может позволить прогнозировать на основе значений данных. Был проведен ряд исследований по использованию прогнозирования стоимости. Shen J.P., Lipasti M.H. в своей книге «Modern Processor Design - Fundamental of Superscalar Processors» опубликовали свои мысли, посвященные оценке концепции прогнозирования стоимости и ее потенциала влияния на эксплуатацию ILP. D 1999 ujle 72. Брэд Колдер, Гленн Рейнман и Дин Таллсен в книге «Selective Value Prediction». исследовали идею селективного предсказания значения. Другие авторы пытались подходить к данной проблеме с точки зрения повторного использования значений, полученных инструкциями. Профессор Andreas Moshovos показал, что решение о прогнозировании ценности, путем отслеживания достижения прирост производительности. Эта область в настоящее время активно развивается, представляя новые результаты, публикуя их на каждой конференции.

В 1994 и 1995 годах были анонсированы широкие суперскалярные процессоры от каждого из основных поставщиков: процессор Intel Pentium PRO и Pentium II (с одинаковой реализацией основной трубопроводной структуры, описанной в 1995году), AMDK-5,K-6, and Athlon;Sun UltraSPARC систем. Последняя часть XX века показала миру вторые поколения многих из этих процессоров (Pentium III, AMD Athlon и Alpha 21264, среди прочих). Второе поколение, хотя и аналогично по скорости выпуска, может поддерживать более низкий CPI и обеспечивать гораздо более высокие тактовые частоты. Все они включали динамическое планирование.

На практике необходимо учесть много факторов, в том числе технологии выполнения, иерархии памяти, мастерство дизайнеров. И все это для того чтобы определить какой подход лучше.

В период с 2000 по 2005 год доминировали три тенденции среди суперскалярных процессоров: внедрение более высоких тактовых частот достигается за счет более глубокой конвейеризации (например, в Pentium 4), введение многопоточности (например, IBM в Power 4 и Intel в Pentium 4 Extreme) и начало о движении к многоядерности (например,от IBM в Power 4, AMD в Opteron).

Еще необходимо отметить одну тенденцию данного периода это активное изменение графических интересов. Раньше они конфигурировались, но не программировались разработчиком приложения. С каждым поколением предлагались дополнительные улучшения. Тем не менее, разработчики становились все более изощренными и просили больше новых особенностей, превосходящие возможности встроенных функции.

GeForce 3 сделал первый шаг к настоящей общей программируемости шейдера. Он дал возможность разработчику приложений частный внутренний набор команд для механизма представления вершин с плавающей запятой. Это совпало с выпуском Microsoft DirectX 8 и расширений вершинных шейдеров OpenGL. Более поздние графические процессоры, вовремя DirectX 9, расширили общую программируемость и возможность представления с плавающей запятой части пикселя и выполненной текстуры. ATI Radeon серии 9700, введенная в 2002 году, включала программируемый 24-битный код с плавающей точкой, в котором процессор фрагмент пикселя запрограммировал с DirectX 9 и OpenGL. GeForce FX добавил 32-разрядные пиксельные процессоры с плавающей запятой. Он был частью общей тенденции к унификации функциональности различных этапов, по крайней мере, для прикладных программ. GeForce от NVIDIA Серии 6800 и 7800 были построены с отдельными конструкциями процессоров и отдельными аппаратными средствами, предназначенными для обработки вершин и фрагментов. XBox 360 представила ранний унифицированный процессор GPU в 2005 году, позволяющий вершинным и пиксельным шейдерам выполнить их на том же процессоре.

По мере появления графических процессоров с поддержкой DirectX 9 некоторые исследователи обратили внимание на скользкий путь роста производительности графических процессоров и начали изучать их использование при решении сложных параллельных задач. Совместимые с DirectX 9 графические процессоры были предназначены только для сопоставления функции, требуемых графическим API. Для доступа к вычислительным ресурсам, программист должен был переводить вопрос в родные графические операции.

Шейдеры не имели средств для выполнения произвольных операций разброса памяти. Единственный способ записать результат в память-это выдать его в виде пиксельного цвета. Его значение и настройка представляются в виде буфера кадров для записи - результат к двумерному буферу кадров. Кроме того, единственный способ получить итог от одного прохода вычисления к следующему, это написать все параллельные результаты для пиксельного буфера кадров, а затем использовать его в качестве карты текстуры входных данных шейдера фрагмента пикселя следующего этапа вычисления. Общее схема вычислений на GPU в эту эпоху были довольно неудобными. Тем не менее, бесстрашный исследователи продемонстрировали несколько полезных приложений с кропотливыми усилиями.

Еще одним важным направление в истории развития вычислительной техники стали микропроцессоры. Трудно отличить первый мультипроцессор MIMD. Удивительно, но первый компьютер из корпорации Эккерта-Мочли, например, имел дубликаты для повышения доступности. Еще в 1959 годы были приведены ранние аргументы в пользу нескольких процессоров. Два из наиболее точно описанных многопроцессорных проекта были осуществлены в 1970-е годы в Университете Карнеги-Меллона. Первым из них который состоял из 16 PDP-11, Соединенных координатный коммутатор на 16 блоков памяти. Он был одним из первых мультипроцессоров с большей, чем несколько процессоров и общей памяти модель программирования.

Большая часть исследований в рамках этого проета была посвящена программному обеспечению, особенно в области ОС. Более поздний мультипроцессор был кластерным с распределенной памятью и неравномерным временем доступа. Это отсутствие кэшей и длительная задержка удаленного доступа сделали размещение данных критичным. Этот мультипроцессор и ряд прикладных экспериментов хорошо описаны различных источниках. Многие идеи были бы повторно использованы в 1980-х, когда микропроцессор сделал создания мультипроцессоров намного дешевле.

В попытке построить крупномасштабные мультипроцессоры, были исследовано два различных направления: мультикомпьютеры передачи сообщений и масштабируемые мультипроцессоры с общей памятью. Хотя было много попыток построить сетчатые и гиперкубсвязанные мультипроцессоры. Один из первых мультипроцессоров успешно был построенн в Калтехе . Это позволило внедрить важные достижения в технологии маршрутизации и межсоединений и существенно снизить стоимость межсоединений, что помогло сделать мультикомпьютер жизнеспособным.

Intel iPSC 860, гиперкуб-Соединенное собрание i860s, было основано на этих идеях. Более поздние мультипроцессоры, такие как Intel Paragon, использовали сети с более низкой размерностью и более высокими индивидуальными связями. Образец также использовал отдельный i860 в качестве контроллера связи в каждом узле. Практическим путем было обнаружено, что лучше использовать процессоры i860 как для вычислений, так и для связи. Возникла идея использовать мультипроцессоры CM-5 и соединение fat tree. Это обеспечило доступ userlevel к каналу связи значительно уменьшив задержку передачи сигнала. В 1995 году эти два мультипроцессора представляли современное состояние в мультикомпьютерах передачи сообщений.

Глава 6. Перспективы

На сегодняшний день мы находимся на следующем этапе развития средств вычислительной техник. Его точные временные промежутки еще не известны, но уже можно с определенной долей вероятности утверждать, что он будет посвящен мобильным технологиям. К его основным характеристикам можно отнести следующее:

- Современный человек носит в рюкзаке карманные компьютеры, которые более мощные, чем почти все компьютеры, которые предшествующие им

- Огромный спрос на handheld (портативные) устройства

- Синхронизация устройств и облачного сервиса

- Распространение геолокации

- Большая востребованность специальных технологий, например, FitBit

- Эволюция операционных систем на устройствах

Сегодня можно выделить несколько наиболее прорывных технологий для вычислительной техники, но отметить хотелось две из них, как наиболее востребованные:

- Технология «Блокчейн»: распределенных баз данных, использующая алгоритмы для надежного учета транзакций. Информацию в системе нельзя изменить, так как более поздние цепочки защищают данные о предыдущих операциях. Основные области применения:

• Идентификация и управления доступом

• P2P транзакции

• Управление цепочками поставок

• Смарт-контракты

• Отслеживаемость информации

• Регистрация актива

- «Интернет вещей»: Программные алгоритмы, реализующие задачи визуального восприятия, принятия решений и др. Концепция ИИ в т.ч. включает машинное обучение – написание самообучающихся программ (т. е. способных становиться более «разумными»). Основные области применения:

• Трейдинговые системы

• Управление рисками и противодействие мошенничеству real-time

• Автоматизированные виртуальные помощники

• Андеррайтинг кредитов и страхование

• Клиентская служба

• Анализ данных и передовая аналитика

Список литературы

- Azizi, O., Mahesri, A., Lee, B. C., Patel, S. J., & Horowitz, M. [2010]. Energyperformance tradeoffs in processor architecture and circuit design: a marginal cost analysis. Proc. International Symposium on Computer Architecture, 26-36.

- Bell, C. G. [1984]. “The mini and micro industries,” IEEE Computer 17:10 (October), 14–30.

- Landstrom, B. [2014]. “The Cost Of Downtime,” http://www.interxion.com/blogs/ 2014/07/the-cost-of-downtime/

- McMahon, F. M. [1986]. The Livermore FORTRAN Kernels: A Computer Test of Numerical Performance Range, Tech. Rep. UCRL-55745, Lawrence Livermore National Laboratory, University of California, Livermore.

- Cvetanovic, Z., and R. E. Kessler [2000]. “Performance analysis of the Alpha 21264-based Compaq ES40 system,” Proc. 27th Annual Int’l. Symposium on Computer Architecture (ISCA), June 10–14, 2000, Vancouver, Canada, 192–202.

- Fabry, R. S. [1974]. “Capability based addressing,” Communications of the ACM 17:7 (July), 403–412.

- Jouppi, N. P., and S. J. E. Wilton [1994]. “Trade-offs in two-level on-chip caching,” Proc. 21st Annual Int’l. Symposium on Computer Architecture (ISCA), April 18–21, 1994, Chicago, 34–45.

- Kessler, R. E. [1999]. “The Alpha 21264 microprocessor,” IEEE Micro 19:2 (March/April), 24–36.

- Texas Instruments [2000]. “History of innovation: 1980s,” www.ti.com/corp/docs/ company/history/1980s.shtml.

- Edmondson, J. H., P. I. Rubinfield, R. Preston, and V. Rajagopalan [1995]. “Superscalar instruction execution in the 21164 Alpha microprocessor,” IEEE Micro 15:2, 33–43.

- Ellis, J. R. [1986]. Bulldog: A Compiler for VLIW Architectures, MIT Press, Cambridge, Mass

- Leiner, A. L., and S. N. Alexander [1954]. “System organization of the DYSEAC,” IRE Trans. of Electronic Computers EC-3:1 (March), 1–10.

- Maberly, N. C. [1966]. Mastering Speed Reading, New American Library, New York

- Разработка регламента выполнения процесса «Расчет заработной платы» (теория реализации операций бизнес-процессов (БП))

- Современная нормативно-правовая база защиты информации

- «Распределенная технология обработки информации»

- Устройство персонального компьютера (Структура и архитектура ПК. Периферийные устройства)

- Местное самоуправление в Российской Федерации: тенденции и перспективы развития (Состав и функции представительного органа муниципального образования в системе органов местного самоуправления)

- «Основы программирования HTML»

- Аналитические регистры налогового учета (Понятие учетных регистров и их оформление)

- Налоги с физических лиц и их экономическое значение (Налоговая система: сущность, функции, принципы построения)

- Рынок ценных бумаг (Государственное регулирование рынка ценных бумаг. Виды ценных бумаг и их характеристика)

- Общие понятия о гражданском праве (Гражданское право, как отрасль права, наука и учебная дисциплина)

- Сервер аутентификации Kerberos (Цербер) (Преимущества аутентификации по протоколу Kerberos. Расширения протокола Kerberos)

- Основы программирования на языке HTML (Основные сведения о языке программирования. Описание создания сайта)