Информация в материальном мире (подробно)

Содержание:

Введение

В последние десятилетия мир переживает информационный взрыв, характеризующий один из признаков перехода индустриального общества к информационному, в основе которого лежат новые информационные технологии, информационные ресурсы, информатизация, информационная сфера, информационное пространство. Происходит коренное изменение способа производства, мировоззрения людей, межгосударственных отношений, сфер и деятельности личности, общества и государства. Основным объектом этой деятельности является информация. В XX веке бурное развитие получили различные средства связи (телефон, телеграф, радио), целью которых была передача сообщений. Однако их функционирование выдвинуло ряд проблем: как обеспечить надежность связи при наличии помех, регистрацию данных, какой способ кодирования сообщения применять в том или ином случае, как кодировать сообщение, чтобы при его минимальной длине обеспечить передачу смысла с определенной степенью надежности. Эти проблемы потребовали разработки теории передачи информации и других немаловажных информационных процессов, различных материальных носителей и способов кодирования.

Цель работы: изучить информацию с точки зрения материального мира.

Задачи:

- Определить понятие информации, данных и сообщений в современной науке и технике.

- Изучить классификацию информации.

- Изучить подходы к определению количества информации.

- Определить процессы сбора, передачи, обработки и накопления информации на примерах.

- Рассмотреть способы кодирования информации на примерах.

Данная курсовая работа состоит из введения, трех глав, в которых раскрывается изучаемая проблем, заключения, списка литературы, приложения.

При написании данной курсовой работы были использованы научная и учебно-методическая литература Российской Федерации.

Основными источниками, раскрывающими понятие информации в материальном мире и теорию информации в целом, явились работы Белова В. М., Панина В. В., Блинова И. В., Попов И., Алексеева А. П., Волькенштейна М.В., А. С. Гуменюка, Н. Н. Поздниченко., Новикова С. Н., Солонской О. И., Лидовского В. В., Стариченко Б. Е., Кудряшова Б. Д., А. Н. Осокин, А.Н. Мальчуков. В данных источниках подробно рассмотрено понятие информации, рассмотрены различия в методах построения классической теории информации К. Шеннона, Хартли и С. Голдмана и дана единая трактовка построения классической теории информации, разобраны такие вопросы как понятие «энтропия», как мера степени неопределенности, измерение информации, передача сообщений, кодирование, помехоустойчивого кодирования и методы сжатия информации,

На основе работ «Основы теории информации» Панина В. В., «Теория информации» Блинова И. В., Попов И. Ю., «Информатика: учебник» Алексеева А. П., «Прикладная теория информации» Гуменюка А.С., «Теория информации» Лидовского В. В., «Теоретические основы информатики» Стариченко Б. Е., «Теория информации» Асокина А. Н., Мальчукова А. Н. подробно рассмотрены теория о понятии информация в материальном мире, свойства, классификация, область применения понятия, способы кодирование, измерения и основные этапы информационного процесса.

В данных источниках представлен отечественный и международный опыт теоретической информатики, как базовой основы информатики, существенной части кибернетики, без которой невозможно полноценного развитие целого комплекса этой области знания.

Объект исследования курсовой работы: теория информации.

Предмет исследования курсовой работы: информации в материальном мире.

Глава 1. Понятие информации, данных и сообщений в современной науке и технике

Определение понятия информации

Информация (от лат. informatio-объяснение, изложение) - это основное понятие информатики. Несмотря на значительные достижения этой науки, ее составляющих, на сегодняшний день нет четкого, однозначного и общепринятого определения информации, отсутствует методология определения значений ее характеристик, что затрудняет решение задач информатики. Это одно из основных неопределенных понятий науки, которое находит свое подтверждение [15]. Существует множество определений понятия информации, которые рассматриваются в литературе: от самых общих, философских (информация - это отражение реального мира) до узко практических (информация - это информация, являющаяся объектом хранения, передачи и преобразования), в том числе и определяемых нормативными правовыми актами [1].

Информация может быть двух типов: дискретная (цифровая) и неразрывная (аналоговая). Дискретная информация характеризуется последовательными точными значениями некоторой величины, а непрерывная— непрерывным процессом изменения некоторой величины. Непрерывную информацию может, например, дать датчик атмосферного давления или датчик скорости автомобиля. Дискретную информацию можно получить с любого цифрового дисплея: электронных часов, счетчика, магнитофона и тому подобное [8].

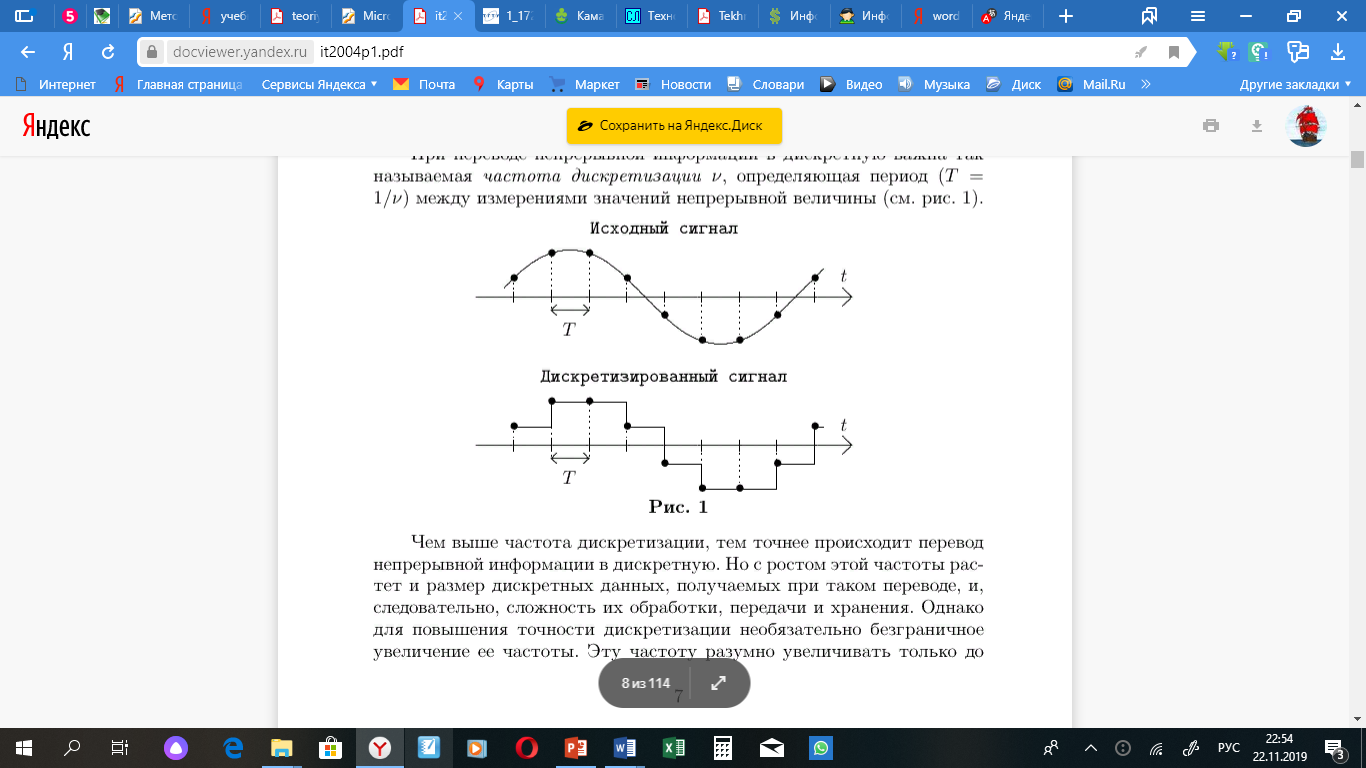

Дискретная информация более удобна для обработки человеком, но непрерывная информация часто встречается в практической работе, поэтому необходимо уметь переводить непрерывную информацию в дискретную (дискретизация) и наоборот. Модем (это слово происходит от слов модуляция и демодуляция) является устройством для такого перевода: он переводит цифровые данные с компьютера в звуковые или электромагнитные колебания-копии звука и наоборот. При переводе непрерывной информации в дискретную важна так называемая частота дискретизации ν, определяющая период (T = 1/ν) между измерениями значений непрерывной величины (см. Рис. 1).

Рисунок 1. Изменение представления непрерывной информации в дискретную форму.

Чем выше частота дискретизации, тем точнее происходит перевод непрерывной информации в дискретную [8]. Но с ростом этой частоты растет и размер дискретных данных, получаемых при таком переводе, и, следовательно, сложность их обработки, передачи и хранения. Однако для повышения точности дискретизации необязательно безграничное увеличение ее частоты. Эту частоту разумно увеличивать только до предела, определяемого теоремой о выборках, называемой также теоремой Котельникова или законом Найквиста (Nyquist) [15].

Любая непрерывная величина описывается множеством наложенных друг на друга волновых процессов, называемых гармониками, определяемых функциями вида A sin(ωt + ϕ), где A — это амплитуда, ω — частота, t — время и ϕ — фаза. Теорема о выборках утверждает, что для точной дискретизации ее частота должна быть не менее чем в два разы выше наибольшей частоты гармоники, входящей в дискретизируемую величину [8].

Примером использования этой теоремы являются лазерные компакт-диски, звуковая информация на которых хранится в цифровом виде. Чем выше частота дискретизации, тем точнее будут воспроизводиться звуки и тем меньше их можно записать на один диск, но ухо обычного человека способно различать звуки с частотой до 20 кГц, поэтому бессмысленно точно записывать звуки с более высокой частотой. Согласно теореме выборки, частота дискретизации должна быть выбрана не менее 40 кГц (промышленный стандарт на компакт-диске использует частоту 44,1 кГц).

При преобразовании дискретных данных в непрерывные определяют скорость этого преобразования: чем она выше, тем больше высокочастотных гармоник получают непрерывное значение. Но чем больше частота встречается в этом значении, тем сложнее с ним работать. Например, обычные телефонные линии предназначены для передачи звуков до 3 кГц. Связь между скоростью передачи и максимально допустимой частотой будет рассмотрена более подробно позже. Устройства для преобразования непрерывной информации в дискретную обобщающе называются АЦП (аналого-цифровой преобразователь) или ADC (Analog to Digital Convertor, A/D), а устройства для преобразования дискретной информации в аналоговую — ЦАП (цифро-аналоговый преобразователь) или DAC (Digital to Analog Convertor, D/A) [8].

Согласно теории Шеннона, понятие информации было определено на вероятностной основе. Информация – информация, сообщения, которые устраняют неопределенность, существовавшую до того, как они были получены полностью или частично [1]. Эта идея информации как снимаемой неопределенности является наиболее распространенной интерпретацией понятия информации.

Информация – сведения об объектах и явлениях окружающей среды, их параметрах, свойствах и состоянии, которые уменьшают имеющуюся о них степень неопределенности, неполноты знаний. Нетрудно увидеть, что по определению информация есть отражение или представление реального мира (чего-нибудь) с помощью сведений (сообщений) [15].

Сообщение – это форма представления информации в виде речи, текста, изображения, цифровых данных, графиков, таблиц и т.п. Тогда в широком смысле можно привести еще одно определение информации [15].

Сообщение – это физическое состояние, определённым образом отличающееся от других физических состояний в цепи управления [4]

Сообщение (message) – упорядоченная последовательность символов, предназначенная для передачи информации [13].

Информация – это общенаучное понятие, включающее в себя обмен сведениями между людьми, обмен сигналами между живой и неживой природой, людьми и устройствами [1].

Наряду с понятием «информация» в информатике часто употребляется понятие «данные».

Данные - информация, представленная в форме, пригодной для ее обработки как автоматическими средствами, так и при участии человека. Естественно, что пока мы не дали строгого определения понятия «информация», мы употребляем этот термин только в его обиходном значении [12].

Данные - это сведения, характеризующие какую-то систему, явление, процесс или объект, представленные в определенной форме и предназначенные для дальнейшего использования [13].

Данные: 1) – сведения, необходимые для какого-нибудь вывода, решения; 2) – факты, идеи, выраженные в формальном виде, обеспечивающем возможность их хранения, обработки, передачи; 3) – факты, идеи, представленные в формальном виде, позволяющем передавать или обрабатывать их при помощи некоторого процесса и соответствующих технических средств; 4) – информация, представленная в формализованном виде, пригодном для автоматической обработки при возможном участии человека; 5) – обобщенное имя информационных продуктов, являющихся предметов труда в информационном производстве [8].

Данные – представление фактов и идей в формализованном виде, пригодном и удобном для фиксации, передачи и переработки в процессе их использования [15].

Классификация информации

Информацию можно разделить на типы в соответствии с различными критериями [15]:

- По способу восприятия:

- Зрительный-воспринимается органами зрения.

- Слуховой-воспринимается органами слуха.

- Тактильные-воспринимаются тактильными рецепторами.

- Обонятельный-воспринимается обонятельными рецепторами.

- Вкус воспринимается вкусовыми рецепторами.

- По форме представления:

- Текст-передается в виде символов, предназначенных для обозначения лексем языка.

- Числовые — в виде чисел и знаков, обозначающих математические действия.

- Графика-в виде изображений, объектов, графиков.

- Звук-устный или в форме записи и передачи языковых знаков слуховыми средствами.

- По назначению:

- Массовая-содержит тривиальную информацию и оперирует набором понятий, понятных большинству общества.

- Специальная-содержит определенный набор понятий, при использовании которых происходит передача информации, которая может быть не понятна основной массе общества, но необходима и понятна в рамках узкой социальной группы, где эта информация используется.

- Секретная-передается узкому кругу лиц и по закрытым (охраняемым) каналам.

- Личная - совокупность сведений об индивиде, определяющая социальный статус и виды социальных взаимодействий внутри популяции.

- По значению:

- Актуальная-информация, которая ценна в данный момент времени.

- Достоверная-информация, полученная без искажений.

- Понятная-информация, выраженная на языке, понятном человеку, которому она предназначена.

- Полная-информация, достаточная для принятия правильного решения или понимания.

- Полезная-полезность информации определяется субъектом, получившим информацию, в зависимости от сферы ее использования.

- По истинности:

- истинная

- ложная

Существует несколько обобщенных классификаций информации: по форме представления, по свойствам, по области проникновения, по способу передачи и восприятия, по общественному назначению, по типу носителя, по типу сигнала и т. П [11].

Подходы к определению количества информации

В качестве основной характеристики сообщения теория информации принимает величину, называемую количеством информации [15]. Это понятие не влияет на смысл и важность передаваемого сообщения, но связано со степенью его неопределенности.

В 1865 году немецкий физик Рудольф Клаузиус ввел в статистическую физику понятие энтропии или меры равновесия системы. В 1921 году основоположник большей части математической статистики, англичанин Рональд Фишер впервые ввел термин «информации» в математику, но полученные им формулы весьма своеобразны [8].

В 1948 году Клод Шеннон в своих работах по теории связи пишет формулы для вычисления количества энергии и энтропии [5]. Термин «энтропия» используется Шенноном по совету Патриарха компьютерной эры фон Неймана, который отметил, что Формулы Шеннона для расчета теории связи совпадали с соответствующими формулами статистической физики, а также тот факт, что «никто точно не знает», что такое энтропия.

Энтропия – это мера неопределенности системы, в частности непредсказуемости появления любого первичного символа алфавита. В последнем случае, при отсутствии потерь информации, энтропия численно равна количеству информации на символ передаваемого сообщения [2].

Например, в последовательности букв, составляющих предложение на русском языке, разные буквы появляются с разной частотой, поэтому неопределенность появления для одних букв меньше, чем для других. Если учесть, что некоторые сочетания букв, в данном случае, говорят об энтропии очень редко, то неопределенность уменьшается еще больше [8].

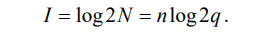

Хартли ввел аддитивную двоичную логарифмическую меру, позволяющую вычислять количество информации в двоичных единицах – битах [15]:

(1)

(1)

При n = 1, q = 2  . Это и есть единица информации Хартли (1). Следовательно, 1 бит информации соответствует одному элементарному событию, которое может произойти или не произойти. Такая мера количества информации удобна тем, что дает возможность оперировать мерой как числом. Количество информации эквивалентно количеству двоичных символов 0 или 1 [6].

. Это и есть единица информации Хартли (1). Следовательно, 1 бит информации соответствует одному элементарному событию, которое может произойти или не произойти. Такая мера количества информации удобна тем, что дает возможность оперировать мерой как числом. Количество информации эквивалентно количеству двоичных символов 0 или 1 [6].

Существует взаимосвязь меры Шеннона с мерой Хартл. Если в источнике может быть реализовано h равновероятных состояний, то вероятность каждого из них  , с учетом этого меру неопределенности источника Хартли

, с учетом этого меру неопределенности источника Хартли  можно трактовать, как количество информации, приходящей на одно дискретное сообщение (поскольку все сообщения источника равновероятные количества информации в каждом из них равны) [8]. В то же время, энтропия по Шеннону – это среднее количество информации, содержащееся в одном из не равновероятных состояний. Она позволяет учесть статистические свойства источника информации. Наряду с рассмотренными мерами Хартли и Шеннона существуют и другие подходы к определению количества информации. Наиболее интересной, наиболее новой явилась информационная концепция Колмогорова [8]. Ее основным тезисом является то, что на основании определения энтропии количество информации связывается с вероятностью наступления Pi. Это выглядит достаточно разумно, т.к. понятие вероятности имеет смысл лишь в связи с массовыми явлениями количества единиц информации в единичном акте и представляющих интерес в связи с данным исходом, оказывается выраженным через вероятности массовых явлений [15].

можно трактовать, как количество информации, приходящей на одно дискретное сообщение (поскольку все сообщения источника равновероятные количества информации в каждом из них равны) [8]. В то же время, энтропия по Шеннону – это среднее количество информации, содержащееся в одном из не равновероятных состояний. Она позволяет учесть статистические свойства источника информации. Наряду с рассмотренными мерами Хартли и Шеннона существуют и другие подходы к определению количества информации. Наиболее интересной, наиболее новой явилась информационная концепция Колмогорова [8]. Ее основным тезисом является то, что на основании определения энтропии количество информации связывается с вероятностью наступления Pi. Это выглядит достаточно разумно, т.к. понятие вероятности имеет смысл лишь в связи с массовыми явлениями количества единиц информации в единичном акте и представляющих интерес в связи с данным исходом, оказывается выраженным через вероятности массовых явлений [15].

Основные понятия теории информации могут быть обоснованы без обращения к теории вероятностей, причем так, что понятия энтропии и количества информации строго приемлемы для отдельных объектов. Однако мера Шеннона интересна не сама по себе, а как основа встроенной теории, позволяющей изменять и расширять существующие предположения о возможностях в области коммуникационных технологий [7].

Выводы по первой главе: определить понятие информации стало для человека жизненно важной необходимостью, так как просто из сведений, которые нас окружают информация стала превращаться в товар, продукт, который имеет свою стоимость. Также очень важно использовать различные подходы к определению количества информации. Измерение объема информации на основе вероятностных событий или с точки зрения информационной концепции будет давать человеку представление о том какое количество информации накопилось или будет накоплено и какое объем для хранение этого объема информации будет необходим.

Глава 2. Характеристика процессов сбора, передачи, обработки и накопления информации

2.1. Сбор информации

Сбор информации является одним из важнейших этапов информационного процесса и в широком смысле означает процесс комплектования системы информационного обеспечения массивами первичных и вторичных документированных источников информации. Применительно к информационным системам, созданным с использованием ЭВТ, используется понятие сбора данных [10].

Сбор данных (data collection) - это процесс идентификации и получения данных из различных источников, группировки полученных данных и представления их в форме, необходимой для ввода в компьютер [8].

Сбор информации связывает систему информационного обеспечения с внешней средой. Эффективность процесса сбора информации (информационного массива) оценивается по показателям полноты, точности, оперативности, актуальности, стоимости, трудоемкости [10].

Полнота - это количественная мера содержания в массиве всех соответствующих документов (информации), существующих в данный момент времени с точки зрения всех пользователей системы [10].

Пертинентность - соответствие содержания документа (информации) информационным потребностям пользователей [15].

Точность - это количественная мера содержания массивов данных (системы) только соответствующих документов (информации). Этот показатель характеризует внутреннее состояние процесса сбора информации, его способность удовлетворять информационные запросы независимо от времени поиска информации [8].

Эффективность - способность процесса сбора выполнить задачу в кратчайшие сроки [8].

Стоимость - способность процесса сбора минимизировать затраты ресурсов на единицу информационного массива [15].

Трудоемкость - способность процесса сбора минимизировать трудозатраты на единицу информационного массива [8].

В рамках процесса сбора осуществляется структурирование информации, определение информационных потребностей объекта (пользователя) и выбор источника информации. Задачей структурирования информации [7] является системная классификация информации с точки зрения удобства ее использования человеком в процессе решения практических задач и удобства обработки и хранения с использованием современных средств и методов.

Выбор источника информации должен основываться из следующих требований: полнота информации, достоверность информации, актуальность информации, релевантность информация, информативность, толерантность информации, функциональная направленность, законность предоставляемой информации, регулярность поступления информации, минимизация затрат ресурсов на ведение информационного инвентаря [9].

Задача оптимального выбора источников информации заключается в выборе из всего имеющегося потенциала наборы таких агрегатов, которые при минимальных затратах затрат и труда будут обеспечивать удовлетворительное регулярных получение необходимой информации, соответствующей перечисленным с вышеуказанными требованиями [14].

Решение таких задач осуществляется известными методами многокритериальная оптимизация.

Многокритериальная оптимизация – способ решения задач нахождения наилучшего (оптимального) результата, удовлетворяют нескольким и не сводимым друг к другу критериям [8].

2.2. Подготовка и передача информации

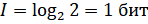

Этап подготовки информации, обрабатываемой информационными системами информации, связан с известным процессом формирования структуры информационного потока, представленного в цифровом виде [10]. Для этого мы используем кодирование информации. Способы представления кодов основаны на применении теорий связей, алгебраических преобразований и геометрических конструкций. Коды, как известно, могут быть представлены формулами, геометрическими фигурами, таблицами, графами, полиномами, матрицами и т. д. примером использования теории связей при формировании кодов является то, что количество комбинаций определяется выбранным методом кодообразования, количеством качественных признаков и общим числом элементов кода [3]. Код можно задать в виде формулы размещения, где кодовые слова представляют собой комбинации, отличающиеся как по самим элементам, так и по порядку их расположения (2):

где m- число качественных признаков (алфавита) кода; n – количество элементов кодового слова. С учетом этого выражения максимальное количество размещений будет при n = m – 1. Можно задать код, в котором кодовые слова представляют соединения, отличающиеся только порядком входящих в них элементов. Для этого используется, формула перестановок [8]:

где m – число качественных признаков (алфавит) кода. Если код представляет собой соединения, отличающиеся только самими элементами, то он задается в виде формулы сочетаний:

Максимальное число сочетаний получается при n = m/2 (для четных m) и n = (m+1)/2 (для нечетных m).

Пример. Для алфавита a, b, c, m = 2, а  3 кодовые слова имеют вид ab, ac, bc. Представление кода в виде многочлена для любой системы счисления с основанием Р соответствует выражению [15]:

3 кодовые слова имеют вид ab, ac, bc. Представление кода в виде многочлена для любой системы счисления с основанием Р соответствует выражению [15]:

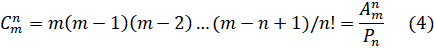

Передача информации в широком смысле рассматривается как рассмотрены процесс и способы формирования и циркуляции информационного потока, который в общем виде представляет собой движение структурированной информации в некоторой информационной среде [10]. Информационные потоки на объекте делятся на входные, внутренние и выходные. В телекоммуникационном канале их можно разделить на односторонние и двухсторонние. Циркуляцией информационных потоков называется факт их регулярного перемещения между различными объектами или между ними различными элементами одного и того же объекта. Основными процессами, обеспечивающими циркуляцию информационных потоков, можно представить в виде схемы (Рис. 2) [15].

Рисунок 2. Схема циркуляции информационных потоков.

Схемы очевидно отражает различные варианты маршрутов циркуляции информации, определяемые количеством релевантных процессы (Рис. 2).

Важное место здесь занимает процесс передачи информации, заключающийся в ее транспортировке с места генерации (от источника) к местам хранения, переработки или использования (потребителю) [10].

В существующих информационных системах различных классов в зависимости от типа используемого носителя и средства обработки можно выделить: устную передачу в прямом общении; передачу бумажных носителей с использованием курьерско-почтовая связь; передача машиночитаемых носителей информации (магнитные карты, перфокарты, перфоленты, магнитные диски и ленты) посредством курьерской почтовой связи; передача в виде различных электрических сигналов по телекоммуникационным каналам связи, в том числе связь по автоматизированным каналам связи [8].

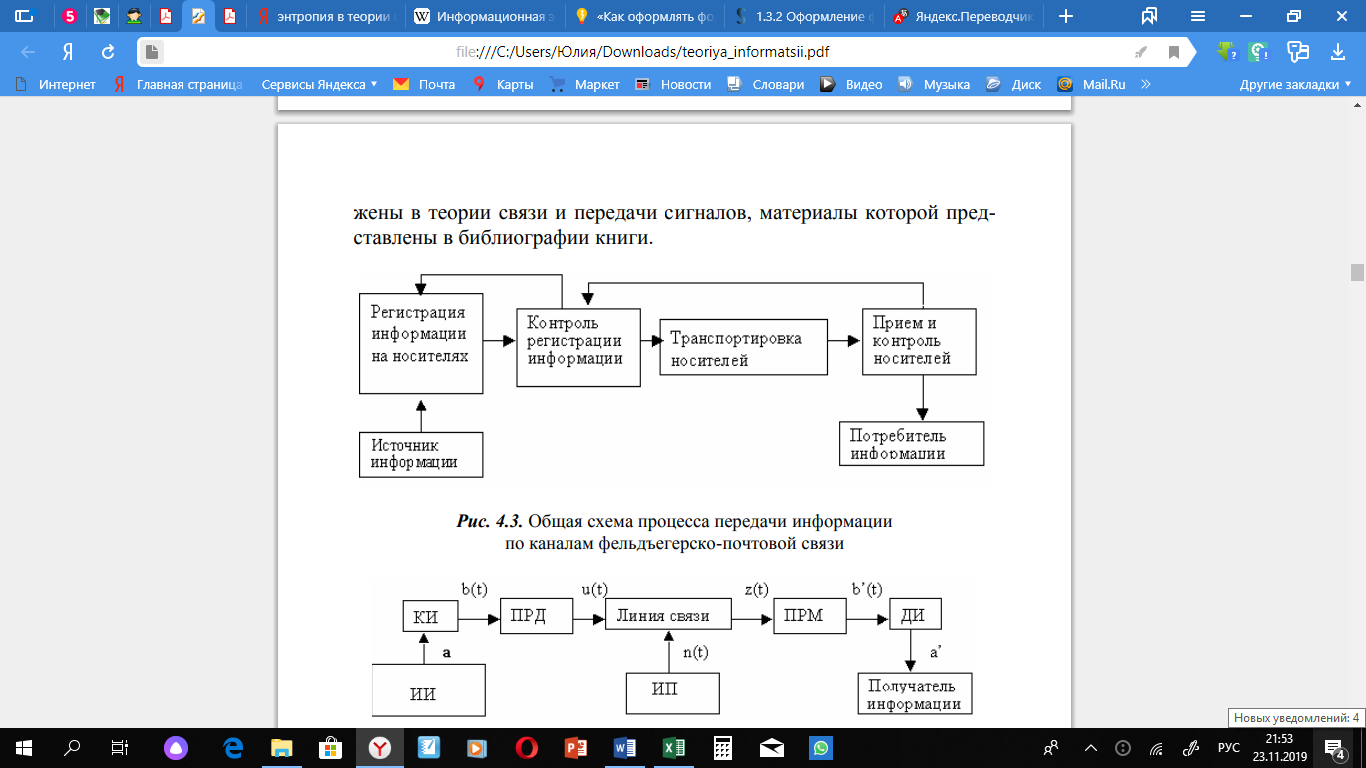

Несмотря на широкое использование технических средств связи, продолжает использоваться курьерская почта коммуникация, в которой передача информации может быть представлена в виде общей схемы (Рис. 3) [8].

Рисунок 3. Общая схема процесса передачи информации по каналам фельдфебельской почтовой службы.

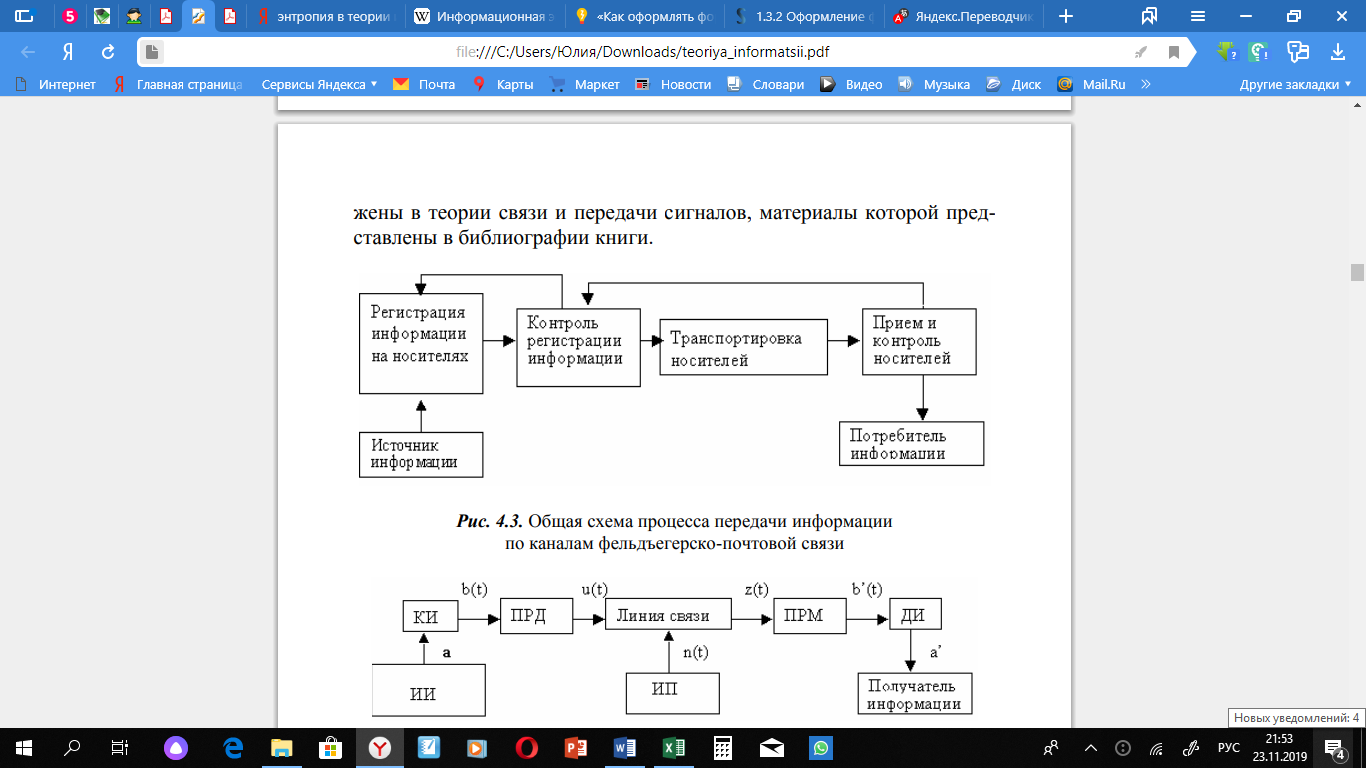

В современных информационно-телекоммуникационных системах передача информации по каналам связи обычно представлена схемой (Рис. 4).

Рисунок 4. Общая схема передачи информации по каналам телекоммуникаций (связи)

Источником информации (ИИ) и ее получателем может быть, как человек, так и различные технические устройства (средства связи, ЭВТ и др.). С помощью кодера исходного устройства (КИ) информация, имеющие любую физическую природу (изображение, звук и т.), преобразуется в первичный электрический сигнал b(t). Для получения непрерывной информации, такой как голосовое сообщение, эта операция сводится к преобразованию звукового давления в пропорциональное изменение электрического тока микрофона, который в каждом момент отсчета (время) может быть представлен конечным числом сигналов, соответствующих отдельным символам исходного алфавита [15].

В телеграфии, последовательность элементов сообщения (букв алфавита) большое количество заменяемых (закодированных) символов (буквы) другого меньшего алфавита. Дальше с помощью технического устройства последовательность кодовых символов преобразуется в последовательность электрических сигналов [].

Процесс преобразования букв сообщений в сигналы преследует несколько целей. Первая цель заключается в преобразовании информации в систему символов, обеспечивающих простоту и надежность аппаратной реализации информационных устройств, а также их эффективность [5]:

- простота технических средств распознавания элементарных символы сообщения;

- сокращение избыточности символов, необходимых с буквой сообщения;

- минимальное время передачи или минимальное количество запоминающих устройств, хранящих информацию;

- простота выполнения арифметических и логических действий с сохраненной информацией.

Кодирование при отсутствии помех в канале связи дает выигрыш во времени передачи или объеме памяти запоминающего устройство, т. е. повышает эффективность работы системы. Это называется эффективным или оптимальным кодированием [5].

Второй, не менее важной целью кодирования, является обеспечение заданной надежности сообщения при передаче или хранении информация путем добавления дополнительной избыточности, но уже по простым алгоритмам и с учетом интенсивности и статистических закономерности возникновения помех в канале связи. Такое кодирование называется помехоустойчивым [8].

Выбор соответствующих устройств кодирования и декодирования зависит от статистических свойств источника сообщения, уровень и характер помех в канале связи. В передатчике (ПРД) первичный электрический сигнал преобразуется во вторичный u(t), пригодный для передачи по соответствующему каналу связи (линии). Это преобразование осуществляется с помощью модулятора [4].

Преобразование сообщения в сигнал должно быть обратимым. Это позволит выходному сигналу восстановить входной первичный сигнал, т. е. получить всю информацию, содержащуюся в передаваемом сообщении. В противном случае часть информации будет потеряна.

Линия связи - это среда, используемая для передачи сигналов от передатчика к приемнику [1].

В телекоммуникационных системах такими линиями являются кабели, волноводы. В системах радиосвязи линии являются пространствами, в котором электромагнитные волны распространяются от передатчика к приемнику. При передаче по линии связи сигналы от источника (ИП) могут быть интерферированы с n(t), что приводит к появлению искажения сигналов.

Приемное устройство, как часть приемника (ПРМ) и декодирующего устройства информации (ДИ), обрабатывает принятый сигнал z(t) = s(t) + n (t) и восстанавливает его в переданное сообщение a', соответствующее источнику информации сообщения a [8].

Система связи – это совокупность технических средств передачи информации и сообщения от источника к потребителю, включая передатчики (КИ, ПРД) и (ДИ, ПРМ) устройства и линии связи [1].

Системы связи различаются по типу передаваемых сообщений, предназначен для передачи речи (телефонной), текста (телеграфной), фотоснимков (фототелеграфной), изображений (телевизионной); вещания сигналов, передачи данных, видеотекст, телетекст, конференцсвязь, телеизмерение и телеуправление и др.

По количеству переданных сообщений на одной линии связи системы делятся на одноканальные и многоканальные.

Канал связи – это совокупность технических средств (ПРД линия связи, ПРМ), обеспечивающие передачу сигналов от источника (КИ) к приемнику сигнала (ДИ) [1].

Классификация каналов связи может осуществляться по ряду показателей:

- по типу сигналов, поступающих на вход канала и удаляемых с его выхода-дискретный, непрерывный, дискретно-непрерывный.

- по способу передачи информации между объектами каналы являются:

- дуплекс, обеспечивающий возможность передачи информации от объекта, а к объекту В, а от объекта К объекту А;

- симплекс, обеспечивающий только передачу информации в одном направлении.

- по структуре источника осуществляется связь с получателями канала связи:

- последовательные линии связи с одним фидером проходят через каждый пункт назначения;

- радиальный-каждый пункт назначения связан с объектом одинофидерной линии;

- древовидные - однофидерные линии не соединены непосредственно с объектом, а соединены с ним через отдельную линию [15].

По типу линий связи каналы делятся на проводные, радиоканалы, оптические, гидроакустические и другое.

2.3. Хранение информации

Хранение информации - это ее запись в вспомогательные запоминающие устройства на различных носителях для последующего использования [15].

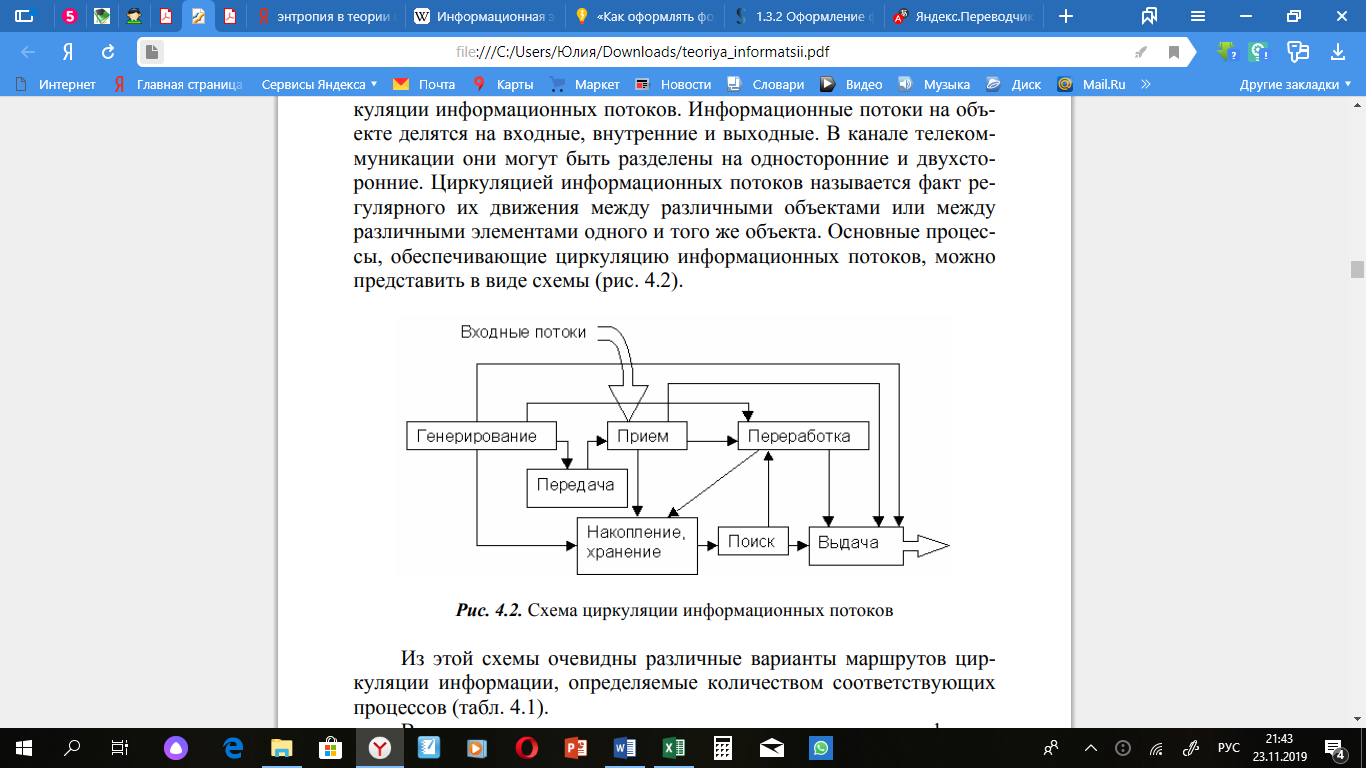

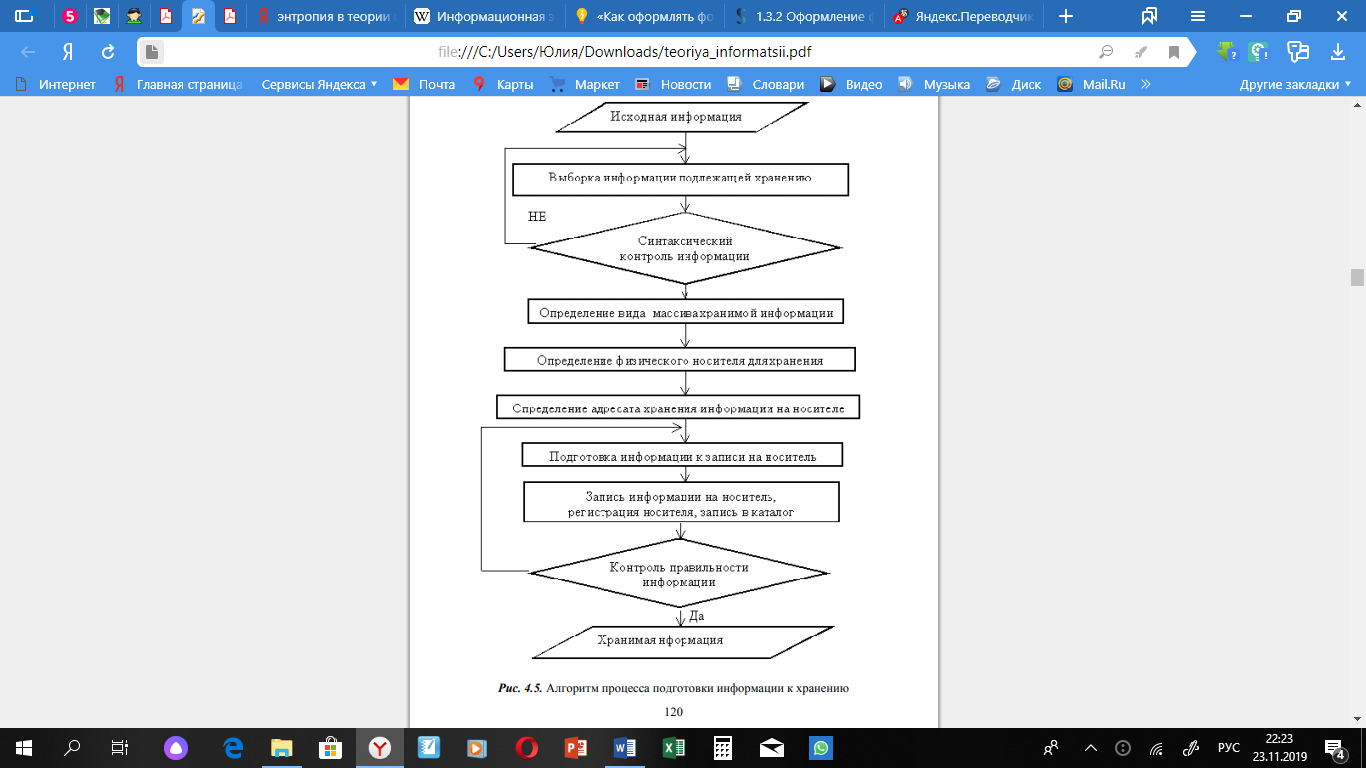

Хранение - это одна из основных операций, осуществляемых над информацией, и основной способ обеспечения ее доступности в течение определенного периода времени [8]. Основным содержанием процесса хранения (удержания хранения) и накопления информации является создание, запись, пополнение и ведение информационных массивов и баз данных (Рис. 5). В результате реализации такого алгоритма документ, независимо от формы представления, поступивший в информационную систему, обрабатывается и затем направляется в хранилище (базу данных), где размещается на соответствующей «полке» в зависимости от принятой системы хранения. Результаты обработки переносятся в каталог [10].

Этап хранения информации может быть представлен на следующих уровнях: внешнем, концептуальном, (логическом), внутреннем, физическом.

Внешний уровень отражает содержание информации и предлагает способы (типы) представления данных пользователю во время осуществления их хранения [4].

Концептуальный уровень определяет порядок организации информационных массивов и способы хранения информации (файлов, массивы, распределенные хранилища, концентрированный и т. д.) [6].

Рисунок 5. Алгоритм процесса подготовки информации к хранению.

Внутренний уровень представляет собой организацию хранения информационных массивов в системе их обработки и определяется разработчиком [15].

Физический уровень хранения относится к реализации хранения информация на конкретных физических носителях [15].

Информация должна хранится так, что она могла быть найдена быстро для будущего использования. Возможность быстрого поиску закладывается в процессе организации процесса запоминания. Для этого используются методы маркировки запоминаемой информации, обеспечивающие поиск и последующий доступ к ней. Эти методы используются для работы с файлами, графическими базами данных. Маркер - метка на носителе информации, указывающая начало или конец данных, или их части (блока). В современных медиа используются маркеры: адреса (address) - код или физическая метка на дорожке диска, указывающая к началу адреса сектора [8].

Хранение информации в ЭВМ связано как с процессом ее арифметической обработки, так и с принципами организации информационных массивов, поиска, обновления, представления информации и т.д. Важным шагом на этапе автоматизированного хранения является организация массивов данных.

Массив - упорядоченный набор данных. Массив данных системы хранения в том числе представление данных и отношений между ними, т. е. принципов их организации. Массивы по своей структуре близки к файлам и отличаются от последних двумя основными признаками: каждый элемент массива может быть явно обозначен, и к нему имеется прямой доступ; число элементов массива определятся при его описании [13].

На физическом уровне любое информационное поле записывается представлены в виде двоичных символов. Доступ к памяти требуется большой объем и большая длина адреса. Информация хранится на специальных носителях. Исторически наиболее распространенным носителем информации была бумага, которая, однако, непригодна в нормальных (не специальных) условиях для длительного хранения информации. На бумагу оказывают вредное воздействие – температурные условия: либо разбухает, либо ломается, способен к воспламенению. Для ЭВТ различают следующие машинные носители по материалу изготовления: бумага, металл, пластик, комбинированные и др [10].

О принципе воздействия и возможности изменения структуры существуют магнитные, полупроводниковые, диэлектрические, перфорационные, оптические и др [1].

По способу считывания различают контактные, магнитные, электрические, оптические. Особое значение при построении информационного обеспечения имеют характеристики доступа к информации, записано на носителе. Выделяются средства прямого и последовательного доступа. Пригодность носителя для хранения информации оценивается по следующим параметрам: время доступа, емкость плотность памяти и записи [15].

Вывод по второй главе: Таким образом, можно сделать вывод, что хранение информации (хранение данных) представляет собой процесс передачи информации во времени, связанный с обеспечением неизменности состояния материального носителя.

Глава 3. Кодирование информации

3.1. Двоичное кодирование

Для автоматизации работы с данными, принадлежащими к разным типам, очень важно унифицировать их форму представления — для этого обычно используется несколько техник кодирования, то есть выражения данных одного типа через данные другого типа. В ВТ существует система кодирования - она называется двоичным кодированием и основана на представлении данных последовательностью всего из двух символов: 0 и 1. Эти знаки называются двоичными цифрами, по — английски-binary digit или сокращенно bit (бит). Один бит может выражать два понятия: 0 или 1 (Да или нет, черное или белое, истинное или ложное и т.). Если количество битов увеличить до двух, то мы можем выразить четыре различных понятия: 00 01 10 11, три бита могут кодировать восемь различных значений: 000 001 010 011 100 101 110 111, увеличивая на единицу количество цифр в системе двоичного кодирования, мы увеличиваем вдвое количество значений, которые могут быть выражены в этой системе, то есть общая формула такова: N=2i, где N — количество независимых кодированных значений; i-разрядность двоичного кодирования, принятая в этой системе. Кодирование целых и вещественных чисел целые числа кодируются двоичным кодом довольно просто — достаточно взять целое число и разделить его пополам, пока частное не станет равным единице. Множество остатков от каждого деления, записанное справа налево вместе с последним частным, и образует двоичный аналог десятичного числа. 19:2 = 9+1 9:2=4+1 4:2=2+0 2:2=1+0. Таким образом, 1910 = 100112. Для кодирования целых чисел от 0 до 255 достаточно иметь 8 бит двоичного кода (8 бит). Шестнадцать бит позволяют кодировать целые числа от 0 до 65 535, а 21 бит — уже более 16,5 миллиона различных значений. 80-битное кодирование используется для кодирования вещественных чисел. Первая часть числа называется мантиссой, а вторая часть-характеристикой.

3.2. Кодирование текстовой информации

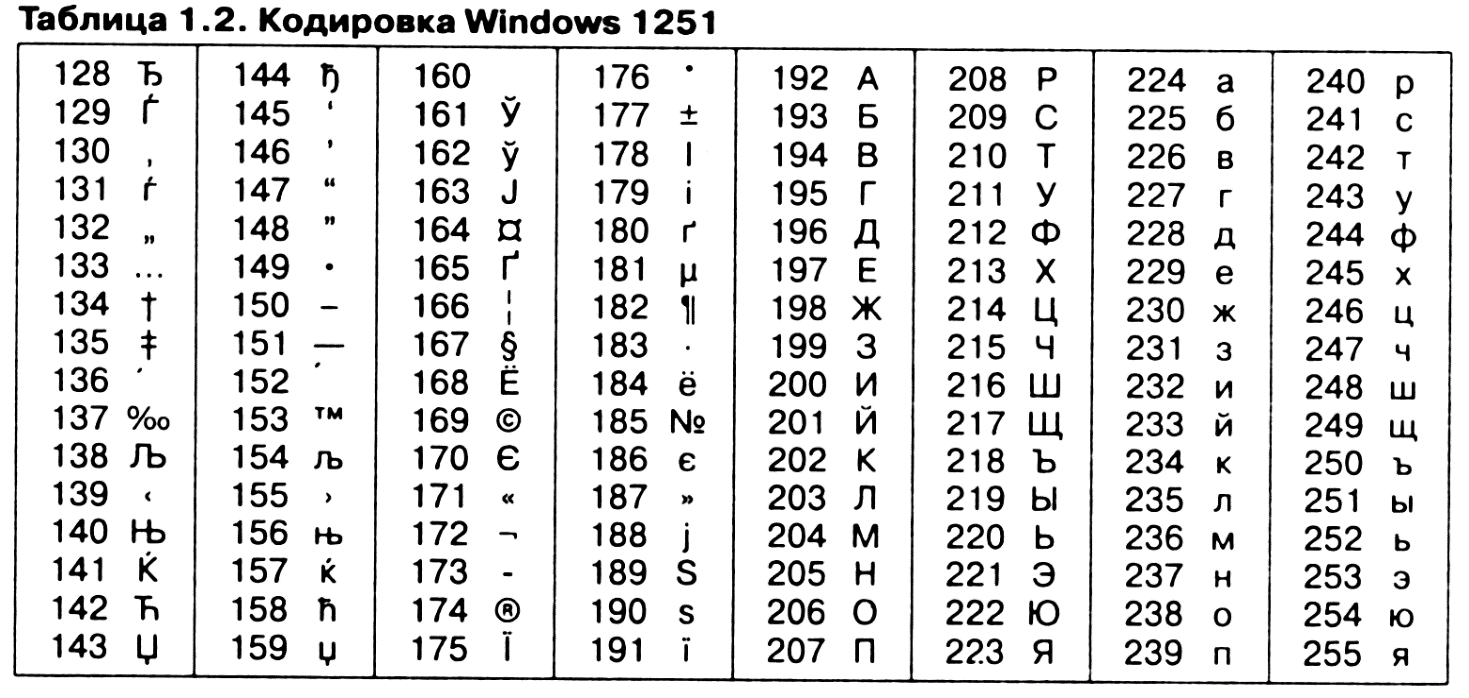

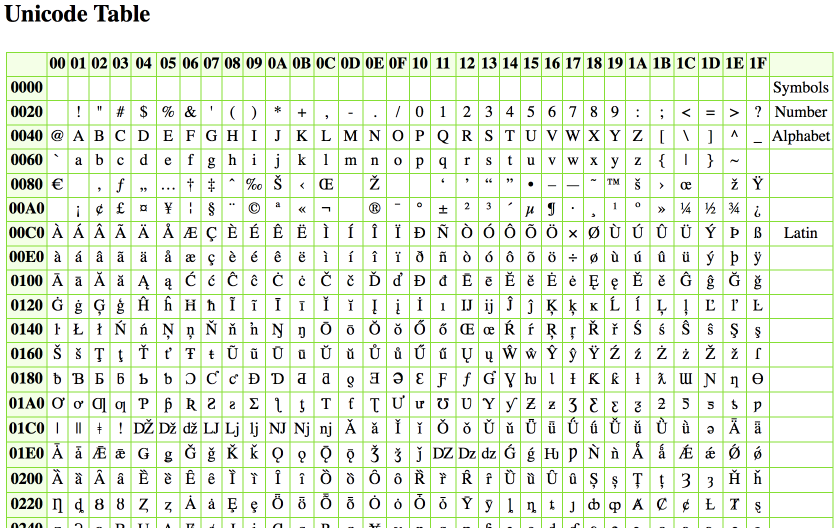

Кодирование текстовой информации. Если каждому символу алфавита присвоено определенное целое число (например, порядковый номер), то двоичный код может кодировать текстовую информацию. Восьми двоичных битов достаточно для кодирования 256 различных символов. Этого достаточно, чтобы выразить в различных комбинациях из восьми бит все символы английского и русского языков, как строчные, так и прописные, а также знаки препинания, символы основных арифметических операций и некоторые общепринятые специальные символы, такие как символ «§» технически это выглядит очень просто, но всегда были довольно значительные организационные трудности. В первые годы развития вычислительной техники они были связаны с отсутствием необходимых стандартов, а сейчас они вызваны, наоборот, обилием одновременно действующих и противоречивых стандартов. Для английского языка, который захватил де-факто нишу международного средства коммуникации, противоречия уже сняты. Американский Национальный институт стандартов (ANSI) ввел систему кодирования ASCII (American Standard Code for Information Interchange) (см. Приложение 1). Система ASCII имеет две таблицы кодирования — базовая и расширенная. Базовая таблица фиксирует значения кодов от 0 до 127, а расширенная таблица относится к символам с числами от 128 до 255. Первые 32 кода базовой таблицы, начиная с нуля, выдаются производителям оборудования (в первую очередь производителям компьютеров и принтеров). В этой области размещаются так называемые управляющие коды, которые не соответствуют никаким языковым символам, и, соответственно, эти коды не выводятся на экран или на печатающее устройство, но ими можно управлять путем вывода других данных. Начиная с кода 32 до кода 127 существуют коды символов английского алфавита, знаков препинания, цифр, арифметических операций и некоторых вспомогательных символов. Универсальная система кодирования текстовых данных если проанализировать организационные трудности, связанные с созданием единой системы кодирования текстовых данных, то можно сделать вывод, что они вызваны ограниченным набором кодов (256). В то же время очевидно, что если, например, кодировать символы не восьми битными двоичными числами, а числами с большим числом цифр, то диапазон возможных значений кодов станет значительно больше. Такая система, основанная на 16-битной кодировке символов, получила название universal — UNICODE (см. Приложение 1). Шестнадцать цифр позволяют предоставить уникальные коды для 65 536 различных символов — этого поля достаточно, чтобы разместить в одной таблице символы большинства языков планеты. Несмотря на тривиальные доказательства такого подхода, простой механический переход к этой системе долгое время сдерживался из-за недостаточных ресурсов компьютерной техники (в системе кодирования UNICODE все текстовые документы автоматически становятся вдвое длиннее). Во второй половине 1990-х годов технические средства достигли необходимого уровня ресурсоемкости, и сегодня наблюдается постепенный переход документов и программного обеспечения на универсальную систему кодирования. Для отдельных пользователей это еще больше усугубило проблемы согласования документов, выполненных в различных системах кодирования, с программным обеспечением, но это следует понимать, как трудности переходного периода.

3.3. Кодирование графической информации

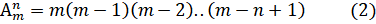

Кодирование графических данных. Если рассмотреть с помощью увеличительного стекла черно-белое графическое изображение, напечатанное в газете или книге, то можно увидеть, что оно состоит из мельчайших точек, образующих характерный узор, называемый растром (Рис. 6).

Рисунок 6. Растр – это метод кодирования графической информации, издавна принятый в полиграфии.

Поскольку линейные координаты и индивидуальные свойства каждой точки (яркость) можно выразить с помощью целых чисел, то можно сказать, что растровое кодирование позволяет использовать двоичный код для представления графических данных. Общепринятым на сегодняшний день считается представление черно-белых иллюстраций в виде комбинации точек с 256 градациями серого цвета, и, таким образом, для кодирования яркости любой точки обычно достаточно восьмиразрядного двоичного числа. Для кодирования цветных графических изображений применяется принцип декомпозиции произвольного цвета на основные составляющие. В качестве таких составляющих используют три основные цвета: красный (Red, R), зеленый (Green, G) и синий (Blue, В). На практике считается (хотя теоретически это не совсем так), что любой цвет, видимый человеческим глазом, можно получить путем механического смешения этих трех основных цветов. Такая система кодирования называется системой RGB по первым буквам названий основных цветов. Если для кодирования яркости каждой из основных составляющих использовать по 256 значений (восемь двоичных разрядов), как это принято для полутоновых черно-белых изображений, то на кодирование цвета одной точки надо затратить 24 разряда. При этом система кодирования обеспечивает однозначное определение 16,5 млн различных цветов, что на самом деле близко к чувствительности человеческого глаза. Режим представления цветной графики с использованием 24 двоичных разрядов называется полноцветным (True Color). Каждому из основных цветов можно поставить в соответствие дополните цвет, то есть цвет, дополняющий основной цвет до белого. Нетрудно заметить для любого из основных цветов дополнительным будет цвет, образованный суммой пары остальных основных цветов. Соответственно, дополнительными цветами являются: голубой (Cyan, С), пурпурный (Magenta, M) и желтый (Yellow, У). Принцип декомпозиции произвольного цвета на составляющие компоненты можно применять не только для основных цветов, но и для дополнительных, то есть любой цвет можно представить в виде суммы голубой, пурпурной и желтой составляющей. Такой метод кодирования цвета принят в полиграфии, но в полиграфии используется еще и четвертая краска — черная (Black, К). Поэтому данная система кодирования обозначается четырьмя буквами CMYK (черный цвет обозначается буквой К, потому, что буква В уже занята синим цветом), и для представления цветной графики в этой системе надо иметь 32 двоичных разряда. Такой режим тоже называется полноцветным (True Color). Если уменьшить количество двоичных разрядов, используемых для кодирования цвета каждой точки, то можно сократить объем данных, но при этом диапазон кодируемых цветов заметно сокращается. Кодирование цветной графики 16-разрядными двоичными числами называется режимом High Color. При кодировании информации о цвете с помощью восьми бит данных можно передать только 256 цветовых оттенков. Такой метод кодирования цвета называется индексным. Смысл названия в том, что, поскольку 256 значений совершенно недостаточно, чтобы передать весь диапазон цветов, доступный человеческому глазу, код каждой точки растра выражает не цвет сам по себе, а только его номер (индекс) в некоей справочной таблице, называемой палитрой.

3.4. Кодирование звуковой информации

Кодирование звуковой информации. Методы и приемы работы со звуковой информацией появились в вычислительной технике совсем недавно. Кроме того, в отличие от числовых, текстовых и графических данных, звуковые записи не имели такой же длинной и проверенной истории кодирования. В результате методы кодирования аудиоинформации двоичным кодом далеки от стандартизации. Многие отдельные компании разработали свои корпоративные стандарты, но в целом есть два основных направления. Метод FM (частотной модуляции) основан на том, что теоретически любой сложный звук может быть разложен на последовательность простых гармонических сигналов различных частот, каждый из которых является регулярной синусоидальной волной, и поэтому может быть описан числовыми параметрами, то есть кодом. В природе звуковые сигналы имеют непрерывный спектр, то есть являются аналоговыми. Их разложение на гармонические ряды и представление в виде дискретных цифровых сигналов осуществляется специальными устройствами-аналого-цифровыми преобразователями (АЦП). Цифроаналоговые преобразователи (ЦАП) выполняют обратное преобразование для воспроизведения звука, закодированного цифровым кодом. При таких преобразованиях неизбежна потеря информации, связанная с методом кодового планирования, поэтому качество записи обычно не совсем было ориентировочным, и оно соответствовало качеству звука простейшего музыкального инструмента цветовой характеристике электронной музыки. В то же время этот метод кодирования дает очень компактный код, и поэтому он использовался в те годы, когда ресурсы компьютерной техники были явно недостаточны.

Метод таблично-волнового (Wave-Table) синтеза лучше соответствует современному уровню развития техники. Проще говоря, можно сказать, что где-то в заранее подготовленных таблицах хранятся образцы звуков для многих различных музыкальных инструментов (хотя и не только для них). В технике такие образцы называются сэмплами. Числовые коды выражают тип инструмента, его номер модели, высоту тона, длительность и интенсивность звука, динамику его изменения, некоторые параметры среды, в которой происходит звук, а также другие параметры, характеризующие характеристики звука. Поскольку в качестве сэмплов используются «реальные» звуки, качество звука, полученного в результате синтеза, очень высокое и приближается к качеству звука реальных музыкальных инструментов.

Выводы по третьей главе: кодирование информации это один из важных этапов информационного процесса. Кодирование информации для ЭВМ это необходимый процесс для полного и правильного восприятия информации, для дальнейшей автоматизации её обработки. Кодирование упрощает процессы передачи, хранения, поиска. Редактирование кодированной информации средствами электронно-вычислительной техники упрощается, информации становится доступной в любом объеме.

Заключение

Информация - это одно из общих понятий, связанных с материей. Информация существует в любом материальном объекте в виде множества его состояний и передается от объекта к объекту в процессе их взаимодействия. Существование информации как объективного свойства материи логически вытекает из известных фундаментальных свойств материи-структурности, непрерывного изменения (движения) и взаимодействия материальных объектов. Любой материальный объект или процесс является первичным источником информации. Все его возможные состояния составляют код источника информации. Мгновенное значение состояний представляется в виде символа этого кода.

Для того чтобы информация передавалась от одного объекта к другому в качестве приемника, необходимо, чтобы существовал некий промежуточный материальный носитель, взаимодействующий с источником. Передача исходной информации в несущую структуру называется кодированием. Таким образом, происходит преобразование исходного кода в носитель кода. Несущая с исходным кодом, переданным ей в виде кода несущей, называется сигналом.

В данной курсовой работе изучалась проблема необходимости использования теории передачи информации и других немаловажных информационных процессов, а также использование различных материальных носителей и способов кодирования при работе с информацией в нашем материальном мире, так как объем фиксируемой информаций необходимый для жизнедеятельности человечества огромен.

Цель курсовой работы была достигнута. Определенно понятие информации, данных и сообщений в современной науке и технике, изучена классификация информации, рассмотрены подходы к определению количества информации, описаны процессы сбора, передачи, обработки и накопления информации на примерах, а также рассмотрены способы кодирования информации на примерах.

Список литературы

- Алексеев, А.П. Информатика 2015: учебное пособие/ Алексеев А.П.— 2015. — 400 с., илл.

- Блинова И. В., Попов И. Ю. Теория информации. Учебное пособие. – СПб: Университет ИТМО, 2018 – 84 с.

- Волькенштейн, М. В. Энтропия и информация / М.В. Волькенштейн. – М.: Наука, 1980 – 112 с.

- Гуменюк, А. С. Прикладная теория информации: учеб. пособие / А. С. Гуменюк, Н. Н. Поздниченко; Минобрнауки России, ОмГТУ. – Омск : Изд-во ОмГТУ, 2015 г.

- Духин, А. А. Теория информации: учебное пособие / А.А. Духин. – М.: Гелиос АРВ, 2014 - 285 с.

- Кудинов Ю. И., Пащенко Ф. Ф. К 88 Основы современной информатики: Учебное пособие. 2-е изд., испр. — СПб.: Издательство «Лань», 2011. — 256 с.: ил.

- Кудряшов, Б.Д. Теория информации: учебник для вузов. – СПб.: Питер, 2009 г. – 320 с., илл.

- Лидовский, В. В. Теория информации: Учебное пособие. — М.: Компания Спутник+, 2004 — 111 с.

- Ляхович, В. Ф. Основы информатики: учебник / В.Ф. Ляхович, В.А. Молодцов, Н.Б. Рыжикова. — Москва: КНОРУС, 2018. — 348 с.

- Осокин А. Н. Теория информации: учебное пособие / А.Н. Осокин, А.Н. Мальчуков; Томский политехнический университет. – Томск: Изд-во Томского политехнического университета, 2019 – 208 с.

- Панин, В. В. Основы теории информации : учебное пособие для вузов /В. В. Панин. — 3-е изд. испр. — М. : БИНОМ. Лаборатория знаний, 2009. — 438 с. : ил.

- Панин В. В. Основы теории информации [Электронный ресурс] : учебное пособие для вузов / В. В. Панин. — 4-е изд. (эл.). — М. : БИНОМ. Лаборатория знаний, 2012. — 438 с. : ил.

- Стариченко, Б. Е. Теоретические основы информатики. Учебник для вузов. – 3-е изд. перераб. и доп. – М.: Горячая линия – Телеком, 2016. – 400 с.: ил.

- Советов, Б.Я., Яковлев С.А. / Моделирование систем: Учебник для вузов. - М.: Высшая школа, 2001. - 320 с.

- Теория информации: учебник для вузов / В.Т. Еременко, В.А. Минаев, А.П. Фисун, И.С. Константинов, А.В. Коськин, В.А. Зернов, ЮА. Белевская, С.В. Дворянкин; под общей научной редакцией В.Т. Еременко, В.А. Минаева, А.П. Фисуна, В.А.Зернова, А.В. Коськина. – Орел: ОрелГТУ, ОГУ, 2015. – 443 с.

Приложение 1

Таблица 1, Таблица 2, Таблица 3, Таблица 4 составлены на основе таблиц Приложения к учебному пособию автора Лидовский, В. В. Теория информации: Учебное пособие. — М.: Компания Спутник+, 2004 — стр. 88 - 97

Таблица 1

Таблица 2

Продожение Приложение 1

Таблица 3

Таблица 4

- Жизненный цикл организации и управление организацией (обобщение и оценка значения жизненного цикла организации и ее управления с теоретической и практической стороны)

- Формирование группового поведения в организации

- Корпоративная культура организации УП Нафтан-сервис

- Адаптация персонала в организациях разных типов

- Роль мотивации в поведении организации (работы по мотивации персонала в организации и предложить пути ее совершенствования)

- Организационная культура и ее роль в современных организациях

- Адаптация персонала в организациях разного типа

- Авторитет и лидерство в системе менеджмента

- Структура нормы права

- Понятие и классификация трудового стажа

- Информация в материальном мире

- Менеджмент человеческих ресурсов